Artykuł Samsung powraca na fotel lidera pochodzi z serwisu CRN.

]]>– O naszym sukcesie, a takim było odzyskanie pierwszego miejsca na globalnym rynku półprzewodników, poza wzrostem sprzedaży pamięci RAM i dysków SSD, zadecydował również wzrost sprzedaży smartfonów z najwyższej półki – podkreśla Maciej Kamiński, dyrektor Samsung Memory w Polsce i regionie CEE.

Jednak nie tylko urządzenia konsumenckie nakręcają popyt na pamięci półprzewodnikowe. Podobny trend występuje w grupie rozwiązań do magazynowania danych bądź backupu. Wprawdzie wielu użytkowników wykorzystuje do wymienionych celów nośniki HDD, ale SSD stanowi bardzo ciekawą alternatywę dla twardzieli.

Samsung rozdaje karty na rynku pamięci półprzewodnikowych (flash memory), będąc nieprzerwanie od 2003 roku światowym liderem tego rynku, co daje mu przewagę nad Intelem w całym biznesie półprzewodnikowym. Nie jest to jednak jedyny atut azjatyckiego producenta. Koreańczycy pod swoją marką produkują bardzo szeroką gamę urządzeń – telewizory, komputery, smartfony czy urządzenia wearables. Samsung w wymienionych produktach wykorzystuje własne półprzewodniki, napędzając tym samym ich sprzedaż. Firma zaopatruje też innych, wiodących dostawców i producentów, którzy montują chipy i pamięci Samsung w swoich urządzeniach.

– Praktycznie w każdym kraju, w większości gospodarstw domowych jest coś, co pochodzi od firmy Samsung, począwszy od telewizora i smartfonu, a na niektórych rynkach także laptopa. Zwykle nie zdajemy sobie też sprawy, że używając produktu innej marki, być może korzystamy na przykład z kości pamięci czy mikrochipa Samsung – mówi Maciej Kamiński.

Zielone chipy

Korea Południowa jest specyficznym krajem o małej powierzchni i dużej gęstości zaludnienia. Dlatego Koreańczycy starają się żyć w zgodzie z otoczeniem i naturą. Zresztą odnosi się to też do przedsiębiorstw działających w tym państwie. Szczególna odpowiedzialność spoczywa na firmie Samsung – największym koreańskim koncernie.

– Lata doświadczeń i rozwoju przełożyły się na sposób prowadzenia lokalnego biznesu. Mam tutaj na myśli podejmowanie działań związanych z optymalizacją produkcji, dbałością o zrównoważony rozwój i tworzeniem przyjaznego człowiekowi miejsca pracy. W firmie Samsung to wszystko w bardzo naturalny i autentyczny sposób zbiegło się w pewnym momencie z globalnymi trendami, wzrostem świadomości i odpowiedzialności ekologicznej – tłumaczy Maciej Kamiński.

Do kluczowych elementów strategii zrównoważonego rozwoju należy również zarządzanie zasobami naturalnymi i odpadami, zmierzanie do zaspokojenia najważniejszych potrzeb społeczeństwa, czy zmniejszanie poziomu bezrobocia oraz ubóstwa.

Jednym z priorytetów koreańskiego producenta jest ograniczanie konsumpcji energii przez urządzenia konsumenckie i biznesowe. Drogą do osiągnięcia tego celu jest miniaturyzacja układów scalonych. Obecnie Samsung wytwarza półprzewodniki o wielkości zaledwie kilku nanometrów, ale koreański producent oraz jego konkurenci nie zamierzają na tym poprzestać. W nieodległej przyszłości mają pojawić się układy o wielkości poniżej 2 nanometrów, czyli dziesiątki tysięcy razy cieńsze niż ludzki włos.

W przypadku producenta półprzewodników niezwykle istotną rolę odgrywa wybór dostawców komponentów. Samsung dochowuje wszelkiej staranności, aby pozyskiwać surowce z zaufanych źródeł z poszanowaniem lokalnego środowiska naturalnego i troską o lokalną społeczność.

– Współpracujemy z podmiotami kontrolującymi cały proces wydobycia i obróbki materiałów i pierwiastków, dbającymi o lokalne środowisko i społeczność. Dzięki takiemu podejściu oraz optymalizacji procesów projektowania i wytwarzania półprzewodników, recyklingu odpadów i ponownego ich wykorzystywania w produkcji w ostatecznym rozrachunku w realny sposób wpływamy na zmniejszenie zużycia energii, wody, a także ograniczenie emisji dwutlenku węgla w całym cyklu dostarczania produktu na rynek– zapewnia Maciej Kamiński.

Samsung Memory nie zamierza w Polsce koncentrować się wyłącznie na sprzedaży produktów i planuje intensyfikować swoje działania proekologiczne. W tym celu firma rozpoczęła współpracę z Martyną Zastawną – jedną z pionierek i liderek idei zrównoważonego rozwoju w Polsce.

Jeszcze więcej edukacji

Dyski półprzewodnikowe bardzo szybko zdobywają rynek, czego przykładem jest segment komputerów, całkowicie zdominowany przez ten rodzaj nośników. Dyski HDD zostały zepchnięte na margines, pełniąc co najwyżej rolę dodatkowego magazynu na dane. Wciąż jednak istnieją obszary, gdzie adopcja pamięci Flash postępuje dość wolno. Samsung planuje przyspieszyć jej tempo, a zdaniem Macieja Kamińskiego jedną z najskuteczniejszych metod jest edukacja partnerów oraz klientów końcowych. Samsung organizuje cykliczne szkolenia, warsztaty oraz webinary, aby za ich pośrednictwem przekazywać wiedzę na temat dysków półprzewodników zarówno od strony technicznej, sprzedażowej, jak i scenariuszy ich wykorzystania w biznesie.

Firma nie chce przy tym ograniczać swoich kontaktów z partnerami do wirtualnych spotkań realizowanych za pośrednictwem Teamsów czy Zooma. Na początku czerwca Dywizja Samsung Memory spotka się na organizowanej przez siebie konferencji z kluczowymi partnerami – retailerami, integratorami i dystrybutorami. W trakcie tego spotkania producent przedstawi najnowsze trendy rynkowe oraz zaprezentuje filary swojej strategii. Będzie to doskonała okazja do nieformalnych spotkań biznesowych, które pozwolą na pogłębianie relacji z partnerami.

Artykuł Samsung powraca na fotel lidera pochodzi z serwisu CRN.

]]>Artykuł Od chromebooka do All in One, czyli ASUS wspiera STEAM pochodzi z serwisu CRN.

]]>Nie jest to wynalazek ostatnich lat. Termin ten pojawił się już kilkadziesiąt lat temu, w Stanach Zjednoczonych. Akronim STEM powstał od pierwszych liter słów w języku angielskim: nauki (science),technologii (technology), inżynierii (engineering) i matematyki (maths). Niedawno listę wzbogacono o literę „A”, odpowiadającą sztuce (ART) i tym samym zaczął obowiązywać nowy termin – STEAM.

ASUS wspomaga STEAM

To truizm, że współczesne społeczeństwo jest napędzane przez matematykę, naukę, technologię i inżynierię. Podobnie jak stwierdzenie, że wraz z coraz większym rozwojem technologii, wzrasta nacisk na wykształcenie wśród uczniów „umiejętności XXI wieku”. Warto przy tym pamiętać, że dużą rolę w tym procesie odgrywają nie tylko nauczyciele, ale też dostawcy sprzętu IT, tacy jak ASUS, który mocno angażuje się w rozwój produktów adresowanych do sektora edukacji.

– Zamiast czytać o technologiach, uczniowie zyskują dostęp do komputerów, robotów, drukarek 3D, sprzętu AV i programów produkcyjnych. Na globalnym rynku pojawia się coraz więcej rozwiązań edukacyjnych wpisujących się w metodologię STEAM. To dla nas bardzo ważny kierunek rozwoju – mówi Sławomir Stanik, ASUS Country Head.

W amerykańskich szkołach bardzo dużą popularnością cieszą się chromebooki. Dzieje się tak z kilku powodów. Komputery z systemem operacyjnym Chrome OS są przystępne cenowo, łatwe w obsłudze i bezpieczne. Z punktu widzenia działu IT, podobnie jak integratora obsługującego szkoły, zaletami chromebooków są łatwość wdrożenia, duże możliwości w zakresie zdalnego zarządzania oraz całodobowa bezpłatna opieka dla administratorów IT.

Niewykluczone, że chromebooki już wkrótce znajdą sobie miejsce w polskich szkołach. ASUS jest jednym z głównych globalnych dostawców tej grupy komputerów. Na szczególną uwagę zasługuje model ASUS Chromebook CX11 z 15,6-calowym ekranem. Urządzenie napędza czterordzeniowy procesor Intela, a bateria wystarcza nawet na 11 godzin pracy. To produkt idealnie nadający się nie tylko dla uczniów oraz studentów, ale również użytkowników, którzy lubią często podróżować.

Jak na razie jednak, w polskich placówkach edukacyjnych królują komputery z systemem operacyjnym Windows. W tym segmencie urządzeń na wyróżnienie zasługuje ASUS BR1100 F – wytrzymały i wydajny laptop z obrotowym i dotykowym ekranem o przekątnej 11,6 cala. Dysponuje wytrzymałą i nowatorską konstrukcją stworzoną pod kątem długiej żywotności.

Choć uczniowie zazwyczaj preferują notebooki, w szkołach dobrze sprawdzają się desktopy. W tej grupie urządzeń ASUS rekomenduje model ExpertCenter D5 Tower. ASUS zapewnia, że komputer może pracować przez długie lata, nie tylko dzięki solidnej obudowie i elementom zabezpieczającym, ale również możliwości łatwej wymiany komponentów.

Inną ciekawą propozycją dla placówek szkolnych poszukujących desktopów jest ExpertCenter E5 AiO 24 – pierwszy na świecie komputer All in One z dodatkowym ekranem dotykowym VeriView. Dwukierunkowa redukcja szumów wspomagana sztuczną inteligencją sprawiają, że urządzenia świetnie sprawdza się podczas telekonferencji. Niewykluczone, że w nieodległej przyszłości do komputerów ASUS-a pracujących w salach lekcyjnych dołączy robot ASUS Zenbo Junior, który wprowadza uczniów w świat programowania.

Artykuł Od chromebooka do All in One, czyli ASUS wspiera STEAM pochodzi z serwisu CRN.

]]>Artykuł Polska – rynek rozwinięty pochodzi z serwisu CRN.

]]>Jeszcze nie tak dawno temu dostawcy, anonsując swoje premierowe produkty, mówili wprost, otwartym tekstem, że Polska jest postrzegana jako rynek rozwijający się, więc to czy inne rozwiązanie zostało przygotowane właśnie dla nas. Warto zwrócić uwagę, że często komunikat ten był podawany w takiej formie, że można go było uznać za komplement, a co najmniej był traktowany ze zrozumieniem i aprobatą. Tu przypomina mi się scena z filmu „Asterix i Obelix: Osiedle Bogów”, w której główny bohater krzyczy do swoich rodaków: „jesteście bandą chciwych kretynów”, na co rozlega się łagodny głos z sali: „o przepraszam, ale kretynami jesteśmy od dawna”. Ja zawsze czułem się dotknięty takimi ofertami „skrojonymi” specjalnie dla nas. Moim zdaniem to tak, jakby powiedzieć kobiecie: ta sukienka jest tania, wprawdzie nie jest zbyt elegancka, ale została zaprojektowana właśnie dla niezbyt urodziwych kobiet, czyli takich jak ty.

Oczywiście, obiektywnie rzecz ujmując, przez długie lata Polska była rynkiem wrażliwym na cenę, ale nic dziwnego, jeśli komputer po obu stronach Odry kosztuje tyle samo, a siła nabywcza portfeli statystycznego obywatela na lewym i prawym brzegu tej rzeki jest jakże inna. Niemniej produkowanie rzeczy pośledniej jakości i tłumaczenie wprost, że są dla nas najlepsze – nigdy nie budziło mojego zrozumienia.

Z tym większą przyjemnością należy odnotować, że opinia, zgodnie z którą Polska jest krajem rozwijającym się należy już do przeszłości. Na pewno można wskazać segmenty rynku, w których cena produktu pozostaje kluczowym kryterium wyboru, jednak nie jest już tak w przypadku sprzętu komputerowego.

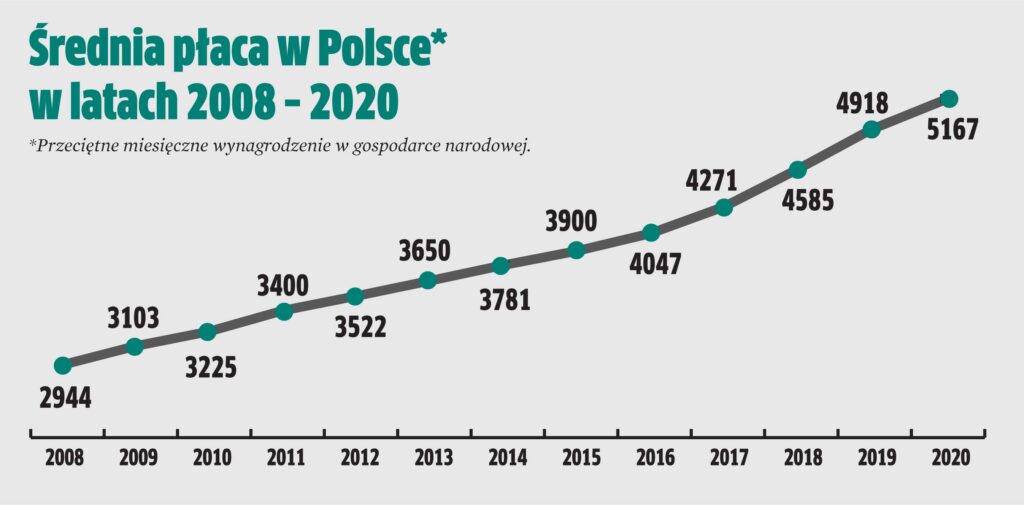

Najlepszym dowodem są ceny najbardziej reprezentatywnego produktu tej grupy, czyli komputera stacjonarnego. Redakcja CRN Polska od ponad dwóch dekad publikuje niemal co rok raport przedstawiający cenę peceta. W publikacji tej przedstawiamy ceny najpopularniejszych w danym roku konstrukcji. W ubiegłym roku miały miejsce dwie radykalne zmiany. Pierwsza dotyczy różnicy w rodzaju najczęściej wybieranych komputerów. Otóż w 2020 r. na cztery sprzedane pecety, aż trzy były notebookami. Druga, to średnia cena notebooka, która wzrosła dwukrotnie.

To spektakularny i bardzo namacalny przykład zmiany trendu, który dotyczy sprzętów z różnych grup produktowych. Statystyczny Polak kupuje coraz droższe komputery przenośne, drukarki czy monitory. Sceptycy powiedzą, że kupujemy droższe, ponieważ… tanich już nie ma i pewnie można znaleźć na to przykłady. Jednakże, gdybyśmy dalej pożądali rozwiązań najtańszych, z pewnością zostałyby one dla nas wyprodukowane. Takie są przecież mechanizmy rynkowe.

Zobacz tegoroczny raport o cenie peceta.

Artykuł Polska – rynek rozwinięty pochodzi z serwisu CRN.

]]>Artykuł Cena peceta: koniec pewnej epoki pochodzi z serwisu CRN.

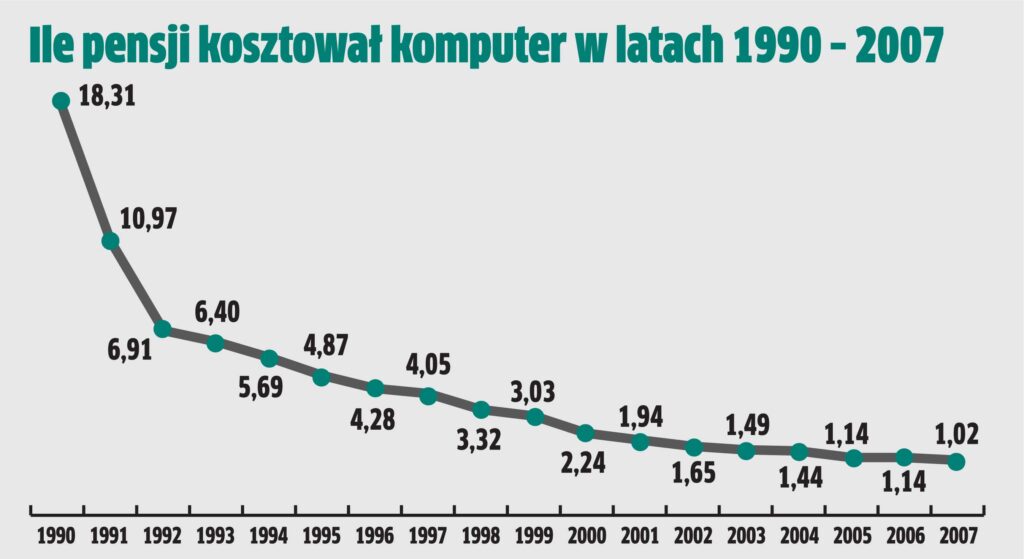

]]>Zanim jednak przejdziemy do tytułowej analizy, sięgnijmy do historii. Gdy 20 lat temu z inicjatywy Adriana Markowskiego, ówczesnego zastępcy red. nacz. Computer Reseller News Polska (dziś CRN Polska), pojawił się pomysł na publikację zestawiającą cenę komputera z innymi dobrami, nikt nie przypuszczał, że powstanie trwający aż dwie dekady cykl. Warto dodać, że w pierwszym artykule dysponowaliśmy informacjami o konfiguracjach i cenach do dziesięciu lat wstecz, czyli de facto nasze zbiorcze dane o cenie peceta obejmują okres aż trzydziestu lat. Od samego początku źródłem informacji był krajowy producent – NTT System. I to właśnie dzięki jego archiwom mogliśmy zestawiać wartość komputera i średniej pensji krajowej począwszy od 1990 r.

– Miałem ambiwalentne odczucia w tej sprawie. Z jednej strony pomysł sam w sobie bardzo mi się podobał, ale z drugiej wymagał ode mnie wielu godzin mozolnej pracy przy „wykopywaniu” archiwalnych danych – wspomina Wojciech Kublin, ówczesny i dzisiejszy dyrektor handlowy NTT System. – Najtrudniej było ustalić dokładne liczby sprzedanych maszyn w poszczególnych konfiguracjach, tak żeby wybrać najpopularniejsze. Swoistym motywatorem były częste telefony od dziennikarza, które uświadomiły mi, że nie uniknę tej pracy.

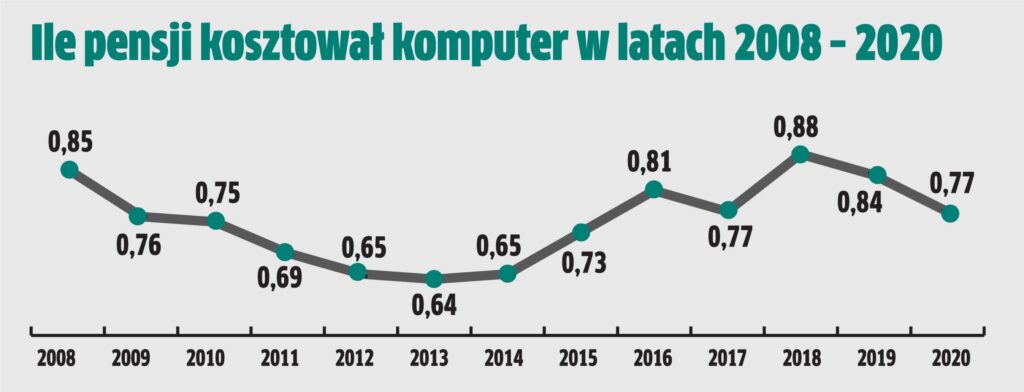

Warto dodać, że uzyskanie z GUS-u informacji o średniej krajowej pensji za okres do 10 lat wstecz w 2000 r., gdy świat drżał przed tzw. efektem millenium – też całkiem proste nie było. Tym bardziej żałujemy, że nie uda nam się zestawić całych trzydziestu lat na wykresie z uwagi na to, że w 1990 r. potrzeba było… ponad 18 średnich krajowych pensji na zakup komputera. Jeśli więc na wykresie linia rzędnych miałaby obejmować 19 jednostek, ostatnie kilkanaście lat byłoby niemal linią prostą, ciągnącą się wzdłuż osi odciętych. A jako że najprawdopodobniej niniejszym artykułem zamykamy cały cykl, i w związku z tym chcemy pokazać wszystkie dane, zrobiliśmy to na dwóch wykresach. Pierwszy obejmuje lata od 1990 do 2007, w którym to roku komputer można było już kupić za jedną pensję. Na drugiej widnieją dane z pozostałych lat, czyli od 2008 do 2020.

Przy okazji wspomnijmy, że w pierwszych latach wartość peceta była zestawiana nie tylko z pensją, ale też z innymi punktami odniesienia, takimi jak dolar czy hamburger. Na liście propozycji była też cena litra paliwa oraz pół litra… innego płynu, ale te – po burzliwych debatach na kolegium redakcyjnym – zostały odrzucone. Przez lata formuła ewoluowała do podawania ceny komputera w kontekście samej średniej krajowej pensji. Z czasem, gdy zaczęła rosnąć sprzedaż notebooków podawaliśmy również ich ceny, ale jako dodatek. Każda z edycji ceny peceta zawierała też informacje o typowych konfiguracjach sprzętu sprzedawanego w opisywanym roku.

W efekcie redakcja CRN Polska może się pochwalić cyklem unikalnych publikacji, które zawierają informacje o tym, ile kosztował komputer w złotówkach i w przeliczeniu na pensje oraz jakie miał konfiguracje. Z reakcji czytelników (zarówno resellerów, jak i dystrybutorów oraz producentów) wiemy, że ten cykl budził zainteresowanie, a nawet emocje. Nie brakowało też głosów krytyki, według których sama idea ustalenia średniej ceny peceta jest tworem sztucznym, a nawet niewiarygodnym. Zawsze w takich przypadkach podkreślaliśmy, że podstawowym celem cyklu jest pokazanie, jak cena zmieniała się przez lata. A wiarygodność zestawienia była i jest gwarantowana przez uzyskiwanie danych w każdym roku z tego samego źródła, jakim był i jest NTT System (to tak, jak przy śledzeniu zmian temperatury, nie tyle ważne jest przyjęcie skali Celsjusza czy Fahrenheita, ile konsekwentne trzymanie się jednej z nich i pokazywanie amplitudy).

Notebooki drożeją 2-krotnie

Ubiegły rok był pod pewnym względem bardzo wyjątkowy, wyróżniający się na tle innych. I wcale nie chodzi o pandemię, ale… procesory. O ile już od kilku lat układy AMD wychodzą z cienia, to ich udział był wciąż marginalny. W zeszłym roku stał się jednak dużo bardziej zauważalny, co widać na przykładzie konfiguracji najpopularniejszych desktopów w ofercie NTT System. Dzięki użyciu procesorów AMD cena przeciętnego peceta była niższa niż dwa lata temu, bo wówczas najwydajniejsze jednostki miały procesory Intela, przez co były droższe. Co ciekawe, jednostki AMD były stosowane w maszynach z wyższej półki. Swoją drogą, to interesujący zbieg okoliczności, bo gdy dwie dekady temu powstawały pierwsze artykuły o cenie peceta, AMD za sprawą swoich Sempronów i Athlonów również szybko zyskiwało na popularności.

Z pewnością warto zwrócić uwagę, że zeszłoroczne komputery stacjonarne i przenośne bardzo nieznacznie różniły się pod względem konfiguracji. Dlatego w 2020 r. stosunkowo łatwo było je porównywać. Zwłaszcza, że w przypadku notebooków od lat „dawcą” danych jest HP, a u tego producenta – w przypadku sprzętu przenośnego – przez cały rok praktycznie najpopularniejszy był jeden model.

– W zeszłym roku sprzedawaliśmy wszystko, co było dostępne, ale niezmiennie, przez wszystkie 4 kwartały, produktem najbardziej poszukiwanym w sektorze MSP+MidMarket był ProBook 450 w cenie 4 tys. zł – mówi Ania Ostafin, Category Manager w HP Inc Polska. – W sektorze Enterprise największym zainteresowaniem cieszył się Elitebook 840 w cenie 6 tys. zł.

Tak się składa…

ProBook 450 to maszyna z ekranem Full HD o przekątnej 15,6-cala. Kluczowe elementy konfiguracji to procesor i5 10210U, 8 GB RAM, SSD 256, całość zamknięta w eleganckiej, aluminiowej obudowie. Jego droższy odpowiednik miał praktycznie takie same komponenty, przy czym, jak przystało na rasowego ultrabooka był dużo lżejszy, z ekranem o przekątnej 14 cali.

W przypadku sprzętu stacjonarnego tanie maszyny miały praktycznie taką samą konfigurację, co notebooki. W desktopach z wyższej półki standardem było 16 GB RAM oraz zewnętrzna karta graficzna. Tu znowu ciekawostka, bo choć w desktopach o dużej wydajności od NTT System znajdowały się procesory AMD, to jednak standardem była grafika od Nvidii – modele 2060 lub 1660, w obu przypadkach z 6 GB RAM na pokładzie. Na przestrzeni minionych dwóch lat nie zmienił się standardowy rozmiar dysku twardego, który był najczęściej nośnikiem SSD o pojemności 256 GB.

W zeszłym roku historia powtórzyła się nie tylko w przypadku zwiększonej popularności jednostek AMD. Z pewnością za zaskakujące należy uznać, że tak jak w odległej przeszłości, tak w zeszłym roku zaczęły dominować C-brandy, czyli komputery produkowane przez resellerów. Dlatego fraza „tak się składa” ma uzasadnienie, skoro prawie dwie trzecie komputerów stacjonarnych, które znalazły użytkowników, to właśnie tzw. składaki. Tak było kilkanaście lat temu, z czasem lokalna produkcja coraz bardziej traciła udziały do nie więcej niż jednej trzeciej rynku desktopów.

Teoretycznie to nic dziwnego, skoro ceny sprzętu A- i C-brandowego praktycznie się nie różnią. Dlaczego zatem komputery składane wracają do łask? Tego nie wiadomo. Można jedynie spekulować, że popyt na takie konstrukcje rośnie, gdy na rynku pojawiają się nowe jednostki AMD – resellerzy mogą je stosować z dnia na dzień, a międzynarodowi producenci potrzebują zwykle miesięcy na ich wdrożenie do oferowanych przez siebie konfiguracji. Czy ta teza jest prawdziwa? Przekonamy się o tym niebawem, bowiem najnowsze procesory AMD, których premiera miała miejsce w kwietniu są dostępne tylko dla markowych producentów. Nie wiadomo, kiedy będą sprzedawane w dystrybucji.

Ceny A.D. 2020

Jak wspomnieliśmy, komputery stacjonarne w zeszłym roku były nieco tańsze, niż dwa lata temu (traf chciał, że w 20-letniej historii ceny peceta było kilka „dziur”, a jedna z nich właśnie w 2019 r.), za sprawą stosowania jednostek AMD. Ale notebooki podrożały w niespotykanej dotąd skali. W 2018 r. najpopularniejsze tanie laptopy kosztowały od 2 do 2,5 tys. zł, zaś ceny tych z wyższej półki nie przekraczały 3,5 tys. zł. Jak widać z cytowanej wypowiedzi Ani Ostafin w zeszłym roku tanie konstrukcje kosztowały więcej niż dwa lata temu drogie, zaś konstrukcje wydajniejsze podrożały niemal dwukrotnie. Warto zauważyć, że w 2018 r. wspomniany ProBook 450 miał status maszyny z wyższej półki, zaś w zeszłym roku już tylko z niższej. Stało się tak z dwóch przyczyn. Pierwsza i najważniejsza jest taka, że statystyczny klient, kupując co najmniej drugi, jeśli nie kolejny komputer, ma dużo większe wymagania, a kryterium ceny ma dużo niższe znaczenie, niż w przeszłości. Przyczyna druga jest dość banalna – klienci kupowali nie tylko to, co chcieli, ale również to, co było dostępne…

Metodologia

Jak wiadomo, w cyklu o cenie peceta porównujemy cenę komputera stacjonarnego ze statystyczną pensją. Wysokość tej ostatniej przyjmujemy za Głównym Urzędem Statystycznym – jest to kwota określana jako „przeciętne wynagrodzenie miesięczne brutto w gospodarce narodowej”. W ubiegłym roku wynosiło ono 5167 zł. Od rocznego uposażenia odejmujemy podatek dochodowy z pierwszego progu, czyli 18 proc., a otrzymaną kwotę (czyli 4237 zł) przyjmujemy za podstawę do dalszych wyliczeń. Średnia cena komputera to średnia desktopa wyliczona z cen dwóch typów desktopów – taniego oraz drogiego. W tabelce zamieszczamy informacje na temat obu typów komputerów z ich konfiguracjami i cenami w każdym kwartale. Ceny te sumujemy i wyliczamy średnią, do której dodajemy wartość średniej klasy monitora, w tym przypadku 600 zł. W wyliczeniach posługujemy się cenami brutto. Zestawiamy średnią cenę komputera ze średnią pensją i w rezultacie ustalamy, jaka jest siła nabywcza portfela statystycznego Polaka w odniesieniu do ceny komputera.

Artykuł Cena peceta: koniec pewnej epoki pochodzi z serwisu CRN.

]]>Artykuł Puls branży IT pochodzi z serwisu CRN.

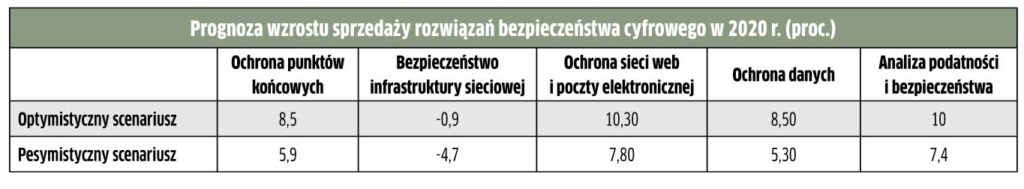

]]>W optymistycznym scenariuszu światowe wydatki na bezpieczeństwo cyfrowe w 2020 r. wzrosną o 5,6 proc. W pesymistycznym – o 2,5 proc., jeżeli budżety IT zostaną mocno ograniczone – prognozuje Canalys. Analitycy przewidują, że tak czy inaczej cyberbezpieczeństwo pozostanie w tym roku priorytetową kwestią dla większości przedsiębiorstw. Przy czym przejście na rozliczenia abonamentowe uchroni je przed natychmiastowymi cięciami wydatków. Przewiduje się jednak, że w br. będzie więcej opóźnień i anulowania projektów, za wyjątkiem tych, które umożliwiają redukcję kosztów oraz zabezpieczają najważniejsze obszary cyfrowej transformacji. Zgodnie z prognozą Canalysa w tym roku znacząco wzrosną wydatki na ochronę punktów końcowych, czego przyczyną jest rozwój pracy zdalnej. Jednak trzeba liczyć się z tym, że tempo wzrostu spadnie po sporych inwestycjach w tym obszarze, jakie miały miejsce w poprzednich miesiącach. Bezpieczeństwo sieci pozostanie największym segmentem rynku z 36-proc. udziałem. Jednak wydatki na nie będą się kurczyć, bo zmienią się priorytety firm. Zamiast skupiać się na tradycyjnej ochronie obwodowej, przesuną one środki na łatanie luk stworzonych przez decentralizację pracy. Będą inwestować w wielowarstwową prewencję oraz wykrywanie i reagowanie. Budżety zostaną również przeniesione na zabezpieczanie chmury.

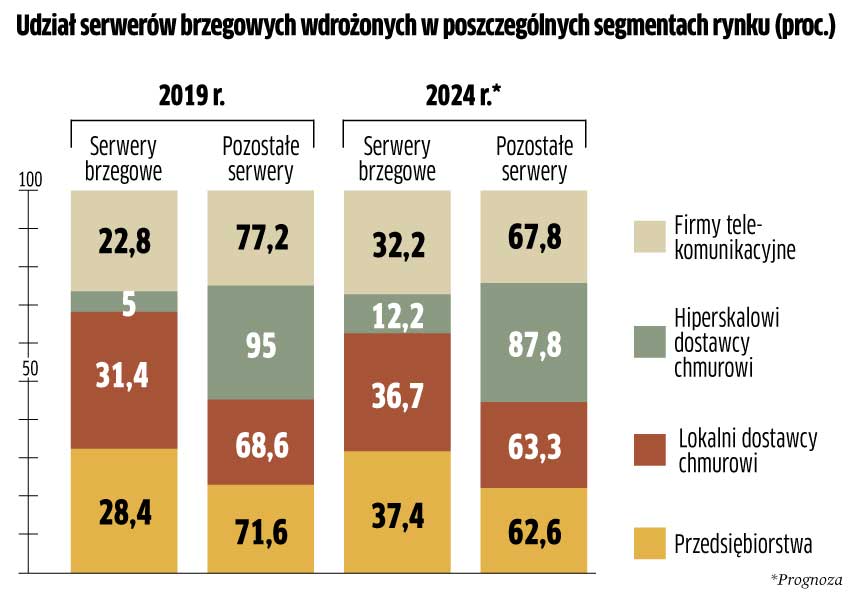

Serwery coraz bardziej na skraju

Klienci z różnych sektorów będą coraz więcej inwestować w edge computing. Dostawy serwerów przeznaczonych do lokalizacji na skraju sieci mają podwoić się w ciągu następnych 5 lat, sięgając poziomu 4,7 mln szt. w 2024 r. – prognozuje Omdia. Przy czym jako serwery brzegowe klasyfikowane są maszyny „odległe” o maksymalnie 20 milisekund od użytkownika końcowego lub urządzenia, biorąc pod uwagę czas przepływu informacji zwrotnej. Jak wyjaśniają analitycy Omdia, zapotrzebowanie na edge computing wiąże się z tym, że zmienia się natura urządzeń i aplikacji. Coraz większego znaczenia nabiera gromadzenie i obróbka danych w czasie rzeczywistym. W serwery „na skraju” będą inwestować zarówno przedsiębiorstwa, jak i oferujące kolokację centra danych, a także operatorzy chmurowi i telekomunikacyjni. Omdia prognozuje, że do 2024 r. ponad 37,5 proc. serwerów dostarczonych do przedsiębiorstw będzie wdrożonych w lokalizacjach brzegowych, w porównaniu z 28,4 proc. w 2019 r. Firmy wcześnie postawiły na przetwarzanie brzegowe w przypadku obciążeń wrażliwych na opóźnienia, np. do aplikacji używanych w ochronie zdrowia i przemyśle, do udostępniania i konsolidacji danych lokalnie, analityki, jak też do zarządzania sklepami detalicznymi. Jednym z czynników zwiększających inwestycje przedsiębiorstw w serwery brzegowe jest rozwój zautomatyzowanej produkcji i wykorzystanie urządzeń Internetu rzeczy.

Użytkownicy modernizują swoje PC

W tym roku rynek kart graficznych ponownie rośnie po dołku w ub.r. W I kw. 2020 r. światowe dostawy wyniosły 9 mln szt., a w II kw. 2020 r. – 9,6 mln szt., co oznacza wzrost o 36,7 proc. wobec analogicznego okresu ub.r. oraz 6,6 proc. kwartał do kwartału. Wartość sprzedaży przekroczyła 3,5 mld dol. Dane obejmują m.in. karty do komputerów i serwerów, jak też instalowane na farmach kryptowalut. Wzrost jest nietypowy jak na okres kwiecień – maj, który jest zwykle słabszy od I kw. (średnio o 6 proc.). Dlatego niezły wynik… niepokoi inwestorów, którzy obawiają się, że zrealizowano już część zakupów, jaka normalnie przypadałaby na III kw. Ponieważ w II kw. 2020 r. rynek desktopów PC spadł o 9 proc., zwiększone zapotrzebowanie na karty graficzne na wolnym rynku wskazuje na to, że użytkownicy w czasie pandemii przystąpili do intensywnej modernizacji swoich komputerów. Za wzrostem sprzedaży kart stoi również popularność gamingu. Przewiduje się, że cyfrowa rozrywka nadal będzie istotnym czynnikiem generującym popyt. Nowym impulsem sprzedażowym mogą być też produkty Intela, który wchodzi na rynek kart graficznych. Być może jego urządzenia pojawią się w sprzedaży już pod koniec III kw. Póki co na rynku jest dwóch głównych graczy – Nvidia i AMD. Jednocześnie analitycy doliczyli się aż 54 producentów gotowych kart graficznych, opartych na obu systemach. Ostatnio widać wyraźnie wzrost zainteresowania kartami budowanymi na platformie Nvidii. W I kw. 2020 r. miały one 69 proc. udziału w rynku, natomiast w II kw. – już 78 proc.

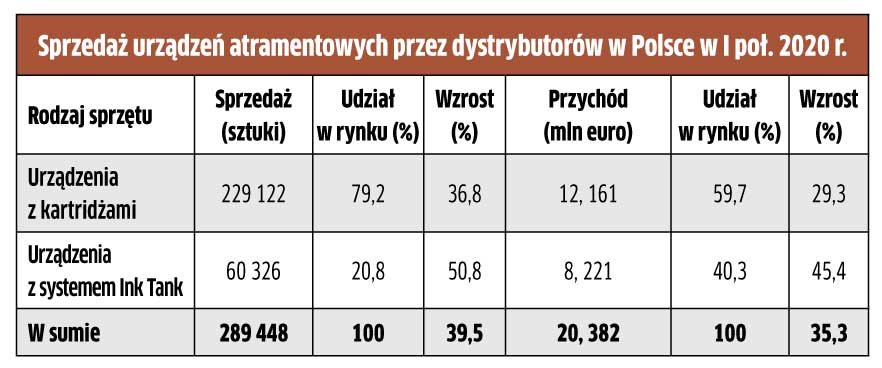

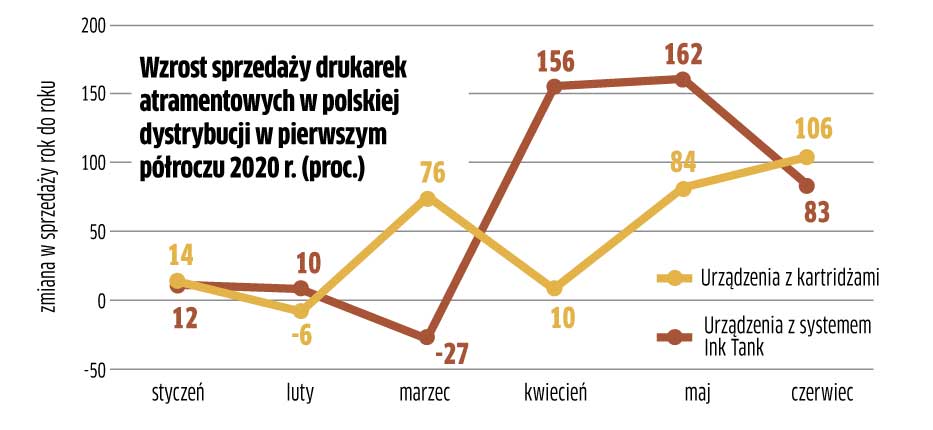

Polski klient polubił tankowanie atramentu

Na rynku „atramentówek” dawno nie było tak udanego półrocza. Od stycznia do czerwca 2020 r. sprzedaż takich urządzeń w polskiej dystrybucji była większa o blisko 40 proc. w porównaniu z analogicznym okresem ub.r. Wartościowo bilans poprawił się o ponad 35 proc. Boom zaczął się w marcu br., gdy wprowadzono blokady związane z koronawirusem. Klienci „rzucili się” zwłaszcza na urządzenia wyposażone w system stałego zasilania w atrament (Ink Tank). Ich sprzedaż była wyższa o ponad 50 proc. niż przed rokiem.

Okazały się atrakcyjne zwłaszcza dla konsumentów, którzy poszukiwali urządzeń do domowych biur. Ich popularność to również konsekwencja niedoboru wkładów atramentowych (kartridży) i zwiększonej, wskutek nagłego skoku popytu, średniej ceny sprzedaży zarówno sprzętu, jak i materiałów eksploatacyjnych. To skłoniło użytkowników do zakupu większej liczby drukarek z systemem Ink Tank. I chociaż są one droższe niż zwykłe drukarki atramentowe, analitycy Contextu spodziewają się dalszego wzrostu ich sprzedaży w nadchodzących miesiącach, choćby ze względu na niskie koszty eksploatacji.

Zarządzanie chmurą będzie warte krocie

Skok zapotrzebowania na rozwiązania cloud computingu sprawi, że kompetencje dotyczące zarządzania systemami chmurowymi będą coraz cenniejsze. Wartość rynku takich usług ma zwiększać się co roku przeciętnie aż o 24,1 proc. (w okresie 2020 – 2025 r.). Oznacza to, że za 5 lat klienci wydadzą na zarządzanie chmurą trzy razy więcej niż w br. (wzrost z 10,6 mld do 31,4 mld dol.). Przewiduje się, że przedsiębiorstwa będą potrzebować zwłaszcza kompetencji w obszarze ITOM, czyli IT Operations Management, które obejmują zarządzanie elementami infrastruktury IT, wymaganiami dla różnych aplikacji, usług, pamięci masowej, sieci i elementów łączności w przedsiębiorstwie. Pozostałe główne segmenty rynku zarządzania usługami w chmurze to ITSM (IT Service Management) oraz ITACM (Automation and Configuration Management). Źródło: MarketsandMarkets

Artykuł Puls branży IT pochodzi z serwisu CRN.

]]>Artykuł Powodzenie przez zasiedzenie? pochodzi z serwisu CRN.

]]>

Pierce Brosnan wyznał w jednym z wywiadów: „Bond mnie uratował”. Możliwość wcielenia się w rolę agenta 007 przyczyniła się do tego, że przygasająca kariera aktora rozbłysła bardzo mocno na wiele kolejnych lat, a i do dziś nie może on narzekać na brak wzięcia. Jaki związek ma kluczowy etap zawodowy aktora ze światem komputerów? Według jednej z teorii spiskowych pecet powiedział: „gaming mnie uratował”. Analogię widać tu jak na dłoni. Urządzenie, które z powodzeniem funkcjonowało przez kilka dekad, zaczęło być zastępowane przez coraz mniejszy sprzęt.

Argument w postaci większej wydajności peceta tracił znaczenie wraz z rozwojem internetu i oprogramowania, które funkcjonując w środowisku sieciowym (czyli ograniczonego transferu), było pisane w taki sposób, żeby jak najmniej obciążać zasoby sprzętowe. Tak powoli kończył się wyścig, w którym sprzęt ciągle gonił aplikacje, zapewniając sobie w ten sposób rację bytu. Jednak, kiedy wydawało się, że wyścig nie ma już sensu, rynek gamingu zaczął dynamicznie rosnąć w siłę, a bardzo wydajny desktop okazał się w zasadzie jedynym narzędziem, które może sprostać wymaganiom stawianym przez najnowsze tytuły.

Oczywiście jest to bardzo duże uproszczenie, bo gaming rozwija się systematycznie przez dekady i zawsze z następującą zasadą: nieustannie rosnące wymagania, za którymi próbują nadążyć możliwości sprzętu. Ale trzeba pamiętać, że dość wcześnie to konsole zaczęły przejmować rynek gier, zyskując na popularności szczególnie w czasach początków nośników typu Blu-ray. Napędy komputerowe czytające takie płyty należały do rzadkości ze względu na wysokie ceny. Były natomiast integralnym elementem konsol, które miały też inne zalety – były gotowe do pracy natychmiast po włączeniu i mogły współpracować z dowolnym ekranem. Jednak konsole zostały zepchnięte na margines gamingu, a entuzjaści elektronicznej rozrywki wybrali peceta. Dostawcy komponentów, takich jak procesory, karty graficzne, pamięci czy płyty główne, mogli odetchnąć z ulgą – znowu wzrósł popyt na ich sztandarowe, najbardziej wydajne, a jednocześnie najdroższe produkty.

Również w biurach nadal standardem pozostaje pecet, zwykle jako komputer przenośny, a gdy jest uzasadniona potrzeba – stacjonarny (kiedyś było odwrotnie). I choć od początku dekady skala integracji komponentów umożliwia schowanie praktycznie pełnowartościowego desktopa w pudełku o gabarytach dwóch kostek masła, to takie konstrukcje zdobywają rynek od stosunkowo niedawna. Prawdopodobnie dlatego, że użytkownicy bardzo powoli zmieniają przyzwyczajenia. Nie jest im łatwo przestawić się mentalnie i zaakceptować, że urządzenie, które przez dziesiątki lat wymagało wielkiego pudła, teraz może być schowane za monitorem, czy wręcz być jego integralną częścią.

Warto jeszcze zwrócić uwagę, że sama konfiguracja sprzętu nie ewoluuje już w sposób liniowy, tak jak było w poprzednich dekadach, gdy pamięci taniały, a ich standardowa pojemność rosła szybko od 1 do 4, a nawet 16 GB. Późniejszy wzrost cen skutkował tym, że przez długie lata 4 GB okazały się wystarczające do większości zastosowań. Również pojemność dysków rosła systematycznie, a użytkownicy wybierali modele 500 GB, 1 TB, potem 2 TB, a nawet 4 TB i byli przekonani o zasadności wyboru. Tymczasem, gdy zyskały na popularności konstrukcje SSD, okazało się, że dysk o pojemności 120 czy 240 GB jest wystarczający do większości zastosowań. Jak widać, potrzeby i ceny się zmieniają, ale stary, dobry pecet trwa w najlepsze.

Artykuł Powodzenie przez zasiedzenie? pochodzi z serwisu CRN.

]]>Artykuł A pecety drożeją, drożeją… pochodzi z serwisu CRN.

]]>Po pierwsze użytkownicy – tak domowi, jak instytucjonalni – przestali kupować sprzęt z niższych półek. Po drugie sprzedaż sprzętu komputerowego ciągle spada – rynek zmniejsza się od kilku lat i choć w zeszłym roku miało być już lepiej, tak się nie stało. Na razie obecny rok też nie zapowiada zmiany trendu. Po trzecie standardowy desktop w obudowie typu ATX odchodzi do lamusa, ale całkiem z rynku nie zniknie. Po czwarte do łask wracają komputery z procesorami AMD. Po piąte wreszcie sprzęt gamingowy stał się tak popularny, że z racji wielkości sprzedaży należy mu się już osobna rubryka w naszym zestawieniu. Na pewno w przypadku desktopów, bo jeśli chodzi o notebooki to na razie jeszcze nie, ale wydaje się, że jest to tylko kwestia czasu.

Spadki od lat

Pierwsza fala spadków popytu zarówno na komputery stacjonarne, jak i mobilne została odnotowana kilka lat temu, w 2015 r. Analitycy przewidywali, że sytuacja taka może potrwać jeszcze rok, dwa z uwagi na to, że rynek zamówień publicznych mocno przystopował, a jednocześnie klienci indywidualni wstrzymali się z zakupami, choć nie bardzo wiadomo z jakiego powodu. Być może dlatego, że czas życia peceta ulega systematycznemu wydłużeniu. Na pewno klienci wstrzymali się z zakupami w 2016 r. ze względu na duży wzrost cen sprzętu przenośnego. Przypomnijmy, że z racji gigantycznych obniżek na przełomie lat 2015 i 2016 – związanych z setkami tysięcy sztuk notebooków zalegających w magazynach dystrybutorów – klienci przywykli do bardzo niskich cen. Gdy w wyczyszczonych magazynach pojawiły się produkty z procesorami kolejnej generacji, a następnie z dyskami SSD, stosunkowo wysokie ceny odstraszały niektórych klientów. Być może niejeden z nich wstrzymał się z zakupem, licząc na rychłą zmianę ceny. Jeśli tak, to w pewnym sensie miał rację, bo sprzęt… dalej drożał.

Nie wiadomo dokładnie, dlaczego rynek się kurczy, wiadomo natomiast, że sytuacja trwa już od kilku lat i dotyczy zwłaszcza segmentu detalicznego. Klienci indywidualni kupili w zeszłym roku o co najmniej 15 proc. notebooków mniej niż w 2017 r., a w przypadku sprzętu stacjonarnego spadek wyniósł kilka procent.

W segmencie biznesowym spadki są w obu kategoriach co najwyżej kilkuprocentowe, trzeba jednak pamiętać, że obecnie punktem odniesienia są lata 2016 i 2017, kiedy notowano duże zmniejszenie popytu. W zeszłym roku producenci z nadzieją wyczekiwali na 2019, spodziewając się wreszcie poprawy koniunktury, ale ten niestety nie następuje. W przypadku sprzętu dla biznesu obiecywano sobie wiele chociażby z uwagi na mnogość zapytań przetargowych oraz finalizowanych projektów, które były przesuwane czy planowane na pierwszy kwartał. Niestety, pierwsze miesiące bieżącego roku wyglądają dokładnie tak jak cały zeszły rok – duże spadki w detalu, zastój w biznesie.

Trzeba jednak zaznaczyć, że o ile spadła liczba sprzedanych desktopów, o tyle znacznie wzrosła ich wartość, bo klienci praktycznie przestali kupować sprzęt najtańszy, który kiedyś stanowił trzon rynku.

Ceny w górę

Choć od kilku lat notujemy systematyczne wzrosty cen sprzętu komputerowego, to należy wyraźnie zaznaczyć, że w Polsce nastąpiła bardzo duża zmiana dotycząca preferencji użytkowników, tak indywidualnych, jak instytucjonalnych. W ofertach producentów dalej są dostępne duże, ciężkie i tanie notebooki w cenach nieprzekraczających 1,5 tys. zł, a także desktopy o bardzo oszczędnych konfiguracjach za niewiele powyżej 1 tys. zł, a nawet tańszych. Taki sprzęt jeszcze kilka lat temu stanowił średnią krajową, ale w zeszłym roku sytuacja uległa radykalnej zmianie – bardzo wzrósł popyt na komputery kosztujące kilka tysięcy złotych.

Oczywiście zjawisko to dało się zaobserwować już kilka lat temu, zwłaszcza w przypadku sprzętu stacjonarnego (od czasu powracającej mody na stosowanie pecetów jako narzędzia do elektronicznej rozrywki), ale dopiero w 2018 r. skala zjawiska wzrosła do tego stopnia, że komputery z wyższych półek wyznaczają średnie ceny sprzętu sprzedawanego na krajowym rynku.

W efekcie najczęściej sprzedawane w zeszłym roku stacjonarne komputery kosztowały od 1,5 do 1,7 tys. zł, podczas gdy jeszcze rok wcześniej ich ceny zawierały się w przedziale 1,18–1,24 tys. zł. Ceny najpopularniejszych laptopów z wyższej półki wzrosły już znacznie w 2017 r., więc nie ma tu tak dużych różnic jak w przypadku desktopów. Podskoczyły jedynie wyraźnie ceny tanich notebooków – w 2018 r. popularne modele (w przypadku HP) kosztowały od 1,86 tys. zł do 2 tys. netto dla resellera, a rok wcześniej ceny te nie przekraczały 1,6 tys. brutto!

Konfiguracje

Jak wspomnieliśmy, przyczyną wzrostów cen komputerów było przede wszystkim to, że użytkownicy przestali kupować modele najtańsze. Z rozmów z producentami wynika jednoznacznie, że klienci zaczęli decydować się na zakup droższych pecetów, dlatego że potaniały komponenty. Najlepszym przykładem są napędy SSD. W zeszłym roku ich ceny zmniejszyły się o połowę, dzięki czemu popyt na dyski półprzewodnikowe wręcz wystrzelił w górę. Jednak choć komponent ten kosztuje dużo mniej niż kiedyś, to ciągle więcej niż tradycyjny dysk magnetyczny, a zatem wybór SSD implikuje wzrost ceny kompletnego urządzenia. Ponadto w niejednym przypadku w komputerze stacjonarnym znajdują się oba rodzaje napędów.

O sukcesie SSD świadczy tabelka z informacjami o konfiguracjach najpopularniejszych desktopów. W ostatnim kwartale 2018 r. tani desktop zawierał taki właśnie napęd i to o pojemności 240 GB. Drugim komponentem, który zaczął tanieć w zeszłym roku, jest pamięć operacyjna. W wyniku redukcji cen modułów RAM standard pamięci w tanich komputerach wzrósł dwukrotnie: z 4 do 8 GB, natomiast w przypadku sprzętu z wyższej półki – z 8 do 16 GB.

W opisie konfiguracji komputerów stacjonarnych AD 2018 trzeba koniecznie zwrócić uwagę na obecność procesorów AMD. Popularność tych jednostek rośnie i to w bardzo szybkim tempie, przy czym należy pamiętać, że startowały one z bardzo niskiego pułapu. Jeszcze w 2017 r. procesory AMD stosowano w ok. 2 proc. produkowanych desktopów, podczas gdy w pierwszej połowie zeszłego roku było to już 4 proc., a w drugiej 8 proc. I wartość ta dalej rośnie. Dane pochodzą od NTT System i nie ma pewności, czy są to liczby reprezentatywne dla całego polskiego rynku. Jedni twierdzą, że jest to więcej, inni, że mniej. Wiadomo za to, że udziały AMD szybko rosną w skali ogólnoświatowej. Z danych uzyskanych od tego producenta wynika, że jego jednostki w zeszłym roku zastosowano w 17,1 proc. desktopów i 13,1 proc. notebooków. Z pewnością do szybkiego wzrostu popularności AMD przyczyniła się redukcja podaży procesorów Intela.

Cena peceta plus

Zestawiając cenę peceta ze średnią pensją krajową, bierzemy pod uwagę dwa typy desktopów – tanie i drogie. W przypadku maszyn tanich wybór jest oczywisty. Producent (nieodmiennie, od pierwszego badania przeprowadzanego na początku poprzedniej dekady, dane na temat cen sprzętu dostarcza redakcji NTT System) wskazuje najtańszy komputer, jaki cieszył się w każdym z kwartałów największą popularnością. Nieco trudniej jest obecnie z wyborem komputera drogiego, bo już od kilku lat do tej kategorii aspirują maszyny do zastosowań gamingowych. Wcześniej trudno było uznać je za punkt odniesienia, ponieważ popyt na tego typu modele w skali całego rynku był stosunkowo niewielki. Jednak z roku na rok staje się on coraz większy i gdy patrzy się na konfiguracje, trudno oprzeć się wrażeniu, że jest to sprzęt przeznaczony dla entuzjastów elektronicznej rozrywki.

Mały kłopot mieliśmy też w przypadku komputerów przenośnych, bo w tym roku producent, od którego od lat pozyskujemy informacje o najpopularniejszym sprzęcie, wpisał do zestawienia ceny resellerskie netto.

Metodologia

Już od kilkunastu lat redakcja CRN Polska porównuje cenę komputera stacjonarnego ze statystyczną pensją. Wysokość tej ostatniej przyjmujemy za Głównym Urzędem Statystycznym – jest to kwota określana jako „przeciętne wynagrodzenie miesięczne brutto w gospodarce narodowej”. W ubiegłym roku wynosiło ono 4585 zł. Od rocznego uposażenia odejmujemy podatek dochodowy z pierwszego progu, czyli 18 proc., a otrzymaną kwotę (czyli 3759 zł) przyjmujemy za podstawę do dalszych wyliczeń.

Średnia cena komputera to średnia wyliczona z cen dwóch typów desktopów – taniego i drogiego. W tabelce na str. 69 zamieszczamy informacje na temat obu typów komputerów z ich konfiguracjami i cenami w każdym kwartale. Ceny te sumujemy i wyliczamy średnią, do której dodajemy wartość średniej klasy monitora, w tym przypadku 600 zł. W wyliczeniach posługujemy się cenami brutto. Zestawiamy średnią cenę komputera ze średnią pensją i w rezultacie ustalamy, jaka jest siła nabywcza portfela statystycznego Polaka w odniesieniu do ceny komputera.

Artykuł A pecety drożeją, drożeją… pochodzi z serwisu CRN.

]]>Artykuł Leasing: opłaci się też resellerom pochodzi z serwisu CRN.

]]>Nad zmianą tej sytuacji pracują rzecz jasna przedsiębiorstwa z sektora bankowego, ale też niektórzy dystrybutorzy oraz producenci IT, oferujący usługi finansowe swoim partnerom i ich klientom. W ten sposób chcą skłonić użytkowników końcowych do zakupu bardziej zaawansowanych, a tym samym droższych rozwiązań informatycznych.

To może się udać, bo sektor leasingu w Polsce rośnie w dwucyfrowym tempie i zajmuje szóstą pozycję w Europie – tak wynika z danych Polskiego Związku Leasingu. Wartość umów zawartych w 2016 r. wyniosła 58,1 mld zł, co oznacza wzrost o 16,6 proc. w porównaniu z rokiem 2015. W ciągu pierwszych dziewięciu miesięcy bieżącego roku firmy leasingowe sfinansowały inwestycje polskich przedsiębiorstw o wartości 47,9 mld zł.

Z oferty leasingodawców korzystają głównie małe przedsiębiorstwa. Branża finansowa kieruje do nich trzy czwarte swoich usług, z czego blisko połowa trafia do firm o obrotach do 5 mln zł. Z najnowszego raportu NFG „Finansowanie działalności przez MŚP w Polsce” wynika, że dwie trzecie podmiotów zaliczających się do MŚP finansuje inwestycje z wypracowanego zysku. Jednak te, które decydują się na wykorzystanie zewnętrznych środków, najczęściej stawiają właśnie na leasing. Wskazało go 21,4 proc. ankietowanych przez NFG firm. Na kolejnych miejscach znalazły się: kredyt bankowy (20 proc.), faktoring (4 proc.), dotacje (3,8 proc.) oraz pożyczki od innych spółek (1,8 proc.). Na marginesie w grupie leasingobiorców pozostaje sektor publiczny i klienci indywidualni.

W pierwszym półroczu 2017 r. najpopularniejszym rodzajem leasingowanych aktywów trwałych były tzw. pojazdy lekkie, które stanowią 48 proc. finansowanych w ten sposób dóbr. Znaczny udział mają również maszyny i urządzenia liczone wraz ze sprzętem IT – prawie 22 proc. Jednak w tym „kawałku tortu” produkty IT stanowią już tylko 6 proc. W porównaniu z danymi sprzed kilku lat, w których była mowa o ok. 2 proc., jest to jednak wyraźny wzrost.

Edukacyjna ofensywa

W Europie, gdzie ogólnie branża leasingowa wkroczyła w trzeci wzrostowy rok (jak wynika z badania Leaseurope Annual Survey 2016), segment leasingu komputerów i maszyn biurowych odnotował… spadek o 7,4 proc. Czy jest to trend, który prędzej czy później skutecznie zahamuje zapotrzebowanie na leasing IT w polskich firmach, zanim zdąży się on na dobre rozwinąć – trudno wyrokować. Na razie trwa akcja edukacyjna skierowana do biznesowych klientów końcowych oraz do kanału sprzedaży.

Jednym z najlepszych przykładów firmy, która stara się uświadomić partnerom i ich klientom zalety zewnętrznego finansowania, jest Lenovo. Producent około roku temu otworzył dział Lenovo Financial Services i zaoferował w leasingu cały swój asortyment. Kolejnym vendorem z branży IT, który swoje rozwiązania oferuje w ramach leasingu, jest Xerox. Liczba transakcji partnerskich finansowanych przez przeznaczony do tego dział rośnie. Zwyżkowe trendy związane z tym rodzajem finansowania potwierdzają też niektórzy dystrybutorzy.

– Rosnące zainteresowanie resellerów usługą leasingu jest spowodowane tym, że korzysta z niej coraz więcej klientów biznesowych – mówi Robert Sejda, New Business Development Manager w AB. – Nie zmienia to jednak faktu, że nadal leasing wymaga aktywnej promocji, zarówno ze strony dystrybutorów, jak i dostawców usług.

Wszystko, nawet software

Do najczęściej leasingowanego sprzętu IT należą komputery i rozwiązania drukujące. Jednak, jak podkreślają komentatorzy, specjalistyczna firma może sfinansować całą infrastrukturę IT potrzebną przedsiębiorstwu. Generalnie resellerzy nie powinni stronić od proponowania klientom wzięcia w leasing: skanerów, projektorów, urządzeń telewizyjnych i radiotechnicznych, aparatów cyfrowych, kas fiskalnych, UPS-ów, centrali telefonicznych, serwerów telekomunikacyjnych czy sprzętu sieciowego.

Komentatorzy z rynku bankowego podkreślają systematyczny wzrost udziału oprogramowania w finansowanych przez nich transakcjach. Według EFL segment finansowania oprogramowania od stycznia do końca września 2017 r. odnotował 67-proc. dynamikę wzrostu rok do roku. W przypadku samego EFL wyniosła ona 16,8 proc.

– Zainteresowany przedsiębiorca może skorzystać z leasingu ERP, CRM, BI, oprogramowania CAD/CAM czy innych kompleksowych systemów informatycznych – mówi Adam Linkiewicz, menedżer ds. rozwoju rynków w EFL.

Dlaczego leasing?

>> Zapewnia klientowi końcowemu łatwiejszy dostęp do sprzętu niż poprzez kredyt – wymagania wobec kondycji firmy są zwykle mniejsze, zaś formalności szybsze i prostsze (niekiedy możliwe do załatwienia w jeden dzień).

>> Nie wymaga inwestowania na starcie firmowych pieniędzy.

>> Daje korzyści podatkowe – w leasingu operacyjnym raty leasingowe i inne opłaty związane bezpośrednio z leasingiem (np. ubezpieczenie sprzętu) w całości stanowią koszt uzyskania przychodu.

>> Zapewnia korzyści bilansowe – leasing operacyjny nie jest uwidaczniany jako zobowiązanie w bilansie, przez co nie pogarsza stosunku zadłużenia do kapitału własnego.

>> Jest sposobem na zabezpieczenie przedsiębiorstwa przed zapóźnieniem technologicznym.

>> Finansowanie zewnętrzne, dzięki stałej racie i możliwości wyboru okresu leasingu, umożliwia dokładne zaplanowanie i lepszą kontrolę wydatków związanych z infrastrukturą teleinformatyczną (harmonogram leasingowy może zostać dostosowany przez przedsiębiorcę do struktury przychodów).

>> Leasingodawcy wymagają mniej zabezpieczeń, gdyż pozostają właścicielami finansowanego przedmiotu (w ramach kontraktu, dzięki efektowi skali, możliwe jest uzyskanie dodatkowych usług w niższych cenach, m.in. ubezpieczenia i serwisu).

Reseller: pierwszy doradca

Istnienie alternatywnych źródeł pieniędzy na IT stwarza szansę rozwoju zarówno resellerom, jak i ich klientom. Firmy informatyczne współpracujące z partnerami oferującymi usługi finansowe dostarczają odbiorcom biznesowym dodatkową wartość – stają się pierwszym doradcą nie tylko w dziedzinie technologii, ale również w kwestii pozyskania pieniędzy na inwestycje. To duże odciążenie dla kontrahenta, więc istnieje szansa, że naprawdę to doceni. Od producentów można usłyszeć, że klienci coraz częściej życzą sobie maksymalnie uproszczonych procedur, w wyniku których pojawią się w firmie potrzebne im urządzenia. Dlatego rodzi się trend przerzucania na dostawców usług nawet formalności związanych z finansowaniem zakupów.

Bardzo możliwe, że przedsiębiorstwa, które przekonają się do leasingowania rozwiązań IT, będą rezygnować z ich wykupu po spłaceniu rat, decydując się na kolejne miesięczne opłaty za nowy sprzęt. Firma informatyczna, przekonując klientów do tego kroku, może im zwrócić uwagę na możliwość ciągłego korzystania z nowoczesnych rozwiązań IT, które, umiejętnie wykorzystane, mogą stanowić duży atut w walce o miejsce na rynku. Jednak – jak mówią specjaliści – dla wielu mniejszych przedsiębiorstw po okresie przewidzianym w umowie leasingu sprzęt nadal jest atrakcyjny. Niewykluczone więc, że korzystając z opcji wykupu, zdecydują się na pozostawienie go w firmie.

To oczywiście nie przekreśla wzięcia przez użytkownika w leasing innych rozwiązań informatycznych, na czym reseller dalej będzie korzystał. Taki scenariusz jest prawdopodobny szczególnie w przypadku, gdy firma się rozwija i musi stworzyć nowe stanowisko pracy lub wkracza w kolejne obszary biznesowe.

Klientom, którym zdecydowanie nie zależy na tym, aby stać się właścicielem sprzętu, ale na jego regularnej wymianie, lepiej jest zaoferować najem długoterminowy. To forma wygodna dla firm, które z definicji muszą korzystać z najnowszych rozwiązań. Przykładem są biura architektoniczne, producenci gier komputerowych, twórcy oprogramowania czy specjaliści od grafiki komputerowej.

Z kim pod rękę?

Dla tradycyjnych resellerów sprawa jest prosta. Współpracę w zakresie oferty leasingowej proponuje niemało podmiotów z sektora bankowego, a także niektórzy dystrybutorzy oraz producenci. Jednym z przykładów jest Grenke, które oferuje resellerom udział w darmowych szkoleniach oraz przyznaje im opiekuna – pomaga on przy zawieraniu umów i może uczestniczyć w negocjacjach z klientem końcowym.

Sprawa może być trudniejsza, jeśli klient ma większe potrzeby niż prosty zakup sprzętu i chce sfinansować z zewnętrznych źródeł zarówno bardziej skomplikowane rozwiązania, jak i usługi okołowdrożeniowe. Tradycyjne firmy z sektora bankowego zapewne nie będą nawet chciały podjąć próby oszacowania ryzyka operacyjnego związanego z bardziej rozległymi wdrożeniami. Między innymi na tym polu swojej przewagi upatruje na przykład Lenovo, które oferuje finansowanie w postaci leasingu operacyjnego pozabilansowego, a więc zbliżonego do najmu. Producent podkreśla fakt, że jako doświadczony gracz z branży IT, może skutecznie pomagać integratorom przy finansowaniu bardziej skomplikowanych projektów realizowanych u klientów końcowych.

Cena czyni cuda

W 2016 r. korzystanie z leasingu zadeklarowało 40 proc. badanych przedsiębiorstw, a zadowolenie z tej formy finansowania wyraziło 80 proc. Tym samym odsetek korzystających z leasingu wzrósł w ciągu roku o 2 p.p., a zadowolonych z leasingu – o 7 p.p. Ponad połowa badanych przez Indicatora (55 proc.) uważa, że główną zaletą tej formy finansowania jest brak potrzeby zakupu produktów na własność. Do kolejnych zaliczono m.in. korzystne rozwiązania podatkowe, na co szczególną uwagę zwracały przedsiębiorstwa, które już korzystały z leasingu. Do minusów leasingu zdaniem badanych należy brak własności przedmiotu (43 proc.). Do najważniejszych czynników wpływających na wybór leasingodawcy respondenci zaliczyli: ofertę cenową (90 proc.), otwartość na negocjacje (79 proc.) i szybkość podejmowania decyzji (76 proc.).

Źródło: Centrum Badań Marketingowych Indicator

Artykuł Leasing: opłaci się też resellerom pochodzi z serwisu CRN.

]]>Artykuł Nie wychodzimy z rynku pecetów pochodzi z serwisu CRN.

]]>wydzielony i działa teraz pod postacią osobnej spółki – Fujitsu Client

Computing. Czy to początek wyjścia z rynku PC?

Marcin Olszewski Nie

ma mowy o sprzedaży działu PC. Nowa spółka jest w 100 proc.

własnością Fujitsu. Przesunięcie jednego z biznesów do osobnej organizacji

to nic nadzwyczajnego. Takie operacje w przeszłości przeprowadzaliśmy już

wielokrotnie. To są zupełnie naturalne zmiany wewnątrz korporacji.

CRN Po co w takim razie przeprowadzono reorganizację?

Marcin Olszewski Celem

jest usprawnienie zarządzania i przyspieszenie podejmowania decyzji.

Ponieważ obecnie zmiany na rynku następują w większym tempie niż jeszcze

kilka lat temu, stworzenie mniejszej organizacji jest jak najbardziej na

czasie.

CRN Jednak pojawiły się spekulacje, że następnym krokiem

może być sprzedaż biznesu PC lub wejście w joint venture z innym

producentem. Ponadto analitycy wymieniają Fujitsu wśród firm, które

w ciągu najbliższych dwóch lat mogą zrezygnować z komputerów.

Marcin

Olszewski Nic mi nie wiadomo

o planach rezygnacji. Posiadanie w portfolio komputerów

i tabletów wpisuje się w naszą strategię, która polega na oferowaniu

przedsiębiorstwom kompleksowych rozwiązań. Komputery są ich elementem, bo takie

są oczekiwania klientów. Mając desktopy czy notebooki w portfolio, my

i nasi partnerzy jesteśmy w stanie lepiej zaspokajać potrzeby

użytkowników.

CRN Czy podział nastąpi także w Polsce? A jeśli

tak, co będzie oznaczać dla waszych partnerów?

Marcin

Olszewski Na naszym rynku nie

nastąpi wydzielenie spółki komputerowej. Fujitsu Polska nadal reprezentuje całe

portfolio Fujitsu. Nie przewidujemy żadnych zmian strukturalnych ani

personalnych w związku z reorganizacją na poziomie globalnym.

Biznesem PC będą u nas zarządzać te same osoby co dotychczas. Nie

planujemy redukcji w tym obszarze, bardziej prawdopodobne jest

powiększenie załogi, bo nasze zespoły, jak i cała organizacja doskonale

sobie radzą na rynku – w kanale sprzedaży w ciągu roku

odnotowaliśmy dwucyfrowy wzrost. Chciałbym podkreślić, że dla naszych partnerów

w Polsce również nic się nie zmienia. Zasady współpracy pozostają te same

jak dotychczas. Nie planujemy większych zmian w programach partnerskich

w bieżącym roku, bo naszym zdaniem dobrze działają.

CRN Jaka będzie zatem strategia Fujitsu na rynku PC?

Marcin Olszewski Kładziemy nacisk na jakość produktów, bo to jest kluczowe dla klientów

biznesowych. Nie mamy ambicji zwiększania sprzedaży za wszelką cenę. Jesteśmy

natomiast w czołówce, jeśli chodzi o bezawaryjność. To zresztą

dotyczy pozostałych produktów. Oprócz tego, tak jak wspomniałem, komputery są

oferowane jako część rozwiązań dla przedsiębiorstw, a nie wyłącznie jako

samodzielne produkty.

CRN Jednak biznes sprzętowy przynosi obecnie najniższe

profity i wiele korporacji ogranicza zaangażowanie na rynku urządzeń,

stawiając na usługi oraz oprogramowanie. Czy Fujitsu również zmierza w tym

kierunku? Niedawno szefem firmy w regionie DACH został menedżer, który

przeszedł z firmy specjalizującej się w usługach ITC.

Marcin Olszewski Od

dawna jesteśmy firmą specjalizującą się w usługach i rzeczywiście ich

znaczenie na rynku rośnie. Ten trend najlepiej widać w segmencie

publicznym w Wielkiej Brytanii, gdzie outsourcing usług jest czymś

naturalnym. Polski rynek dojrzewa do tego etapu, ale wciąż więcej jest

wewnętrznych działów IT. Z pewnością jednak będzie zmierzać

w kierunku modelu brytyjskiego, a więc widać potencjał wzrostu

znaczenia usług. Klienci już teraz pytają głównie o kompleksowe

rozwiązania, czyli usługi powiązane z urządzeniami. Maleje zaś

zainteresowanie samym sprzętem i projektami obejmującymi jeden rodzaj

produktów.

CRN Wasi partnerzy

powinni więc przygotowywać się do oferowania kompleksowych rozwiązań.

W jaki sposób?

Marcin

Olszewski Dla integratorów będzie

ważna przede wszystkim specjalizacja i związana z nią wiedza oraz

kompetencje. Będą one kluczowe, aby w przyszłości oferować rozwiązania na

potrzeby jakiejś konkretnej branży. Integratorzy muszą dobrze rozumieć biznes

klienta, dlatego inwestujemy w kompetencje partnerów. W ciągu

ostatnich kilku lat dwukrotnie powiększył się nasz dział wsparcia sprzedaży.

Zmieniliśmy w istotny sposób podejście do współpracy. Jeszcze 5–6 lat temu

dział presales koncentrował się na doradztwie w zakresie infrastruktury.

Dziś skupia się na wspomaganiu partnera w tworzeniu pełnej architektury

rozwiązań, bo takie jest zapotrzebowanie rynku. Zachęcamy także dystrybutorów

do budowania kompetencji w tym zakresie.

CRN Jakich specjalizacji oczekujecie od partnerów?

Marcin Olszewski

Chcemy osiągnąć efekt synergii z partnerami, którzy oferują więcej niż my.

Zależy nam przede wszystkim na współpracy z firmami, które tworzą własne

rozwiązania aplikacyjne, zwłaszcza specjalistyczne dla różnych branż.

Przykładowo systemy wspomagające sprzedaż w placówkach handlowych albo

analizę Big Data. Fujitsu nie jest skoncentrowane na produkcji aplikacji,

a nawet jeśli mamy własne oprogramowanie (dajmy na to dla handlu), to nie

znaczy, że jest ono dostosowane do rynku polskiego. W lokalnych realiach

często tańsze i lepsze są rozwiązania rodzimych firm. Nie zamierzamy

z nimi konkurować, zamiast tego nastawiamy się na współpracę

w przygotowaniu rozwiązań dla większej grupy klientów, ponieważ umożliwia

to obniżenie kosztów.

CRN Na jakich obszarach, poza wspomnianym handlem i Big

Data, zamierzacie skoncentrować się współpracując z polskimi partnerami?

Marcin Olszewski Do

głównych obszarów zainteresowania należy rynek publiczny, który ma duży udział

w naszym biznesie, zresztą jak w każdej korporacji. Kolejne to rynek

telekomunikacyjny, bankowy oraz medyczny. W tych sektorach działają już

wyspecjalizowani integratorzy i widzimy duży potencjał do współpracy

z nimi. Sami też mamy spore kompetencje – na świecie wdrożyliśmy

wiele projektów wspomagających sektor medyczny. W tym przypadku boom jest

dopiero przed nami. Wprawdzie rynek ten jest zdominowany przez zamówienia

publiczne, ale nowe regulacje prawne mogą przyspieszyć rozwój sektora

prywatnego. Chodzi np. o zmiany w zakresie przechowywania danych

osobowych, co ma wpływ na usługi data center.

CRN Wielu producentów i integratorów nastawia się także

na segment bezpieczeństwa…

Marcin Olszewski To

obszar kluczowy również dla nas i naszych partnerów. Zwłaszcza

specjalizacje powiązane z biometrią, jak rozpoznawanie dłoni i głosu,

będą zyskiwać na znaczeniu. Wprowadzamy rozwiązania kontrolujące wstęp osób na

określony obszar, np. na potrzeby stadionów czy zakładów zamkniętych.

Z kolei banki zaczynają wdrażać podpisy biometryczne, które można stosować

w domu. Oczywiście także backup jest ważny dla firm. To, co nas wyróżnia,

to kompleksowe podejście. Nie skupiamy się na ofercie dostawy storage’u

określonego typu. Ważniejsze jest rozwiązanie jakiegoś problemu klienta dzięki

naszej ofercie. Usługi świadczone wokół infrastruktury, a tutaj w grę

wchodzą m.in. jej zabezpieczenia, to naturalny kierunek rozwoju dla Fujitsu

w Polsce.

CRN Tworzycie nową platformę rozwiązań chmurowych MetaArc.

Fujitsu powalczy o większy udział w rynku usług cloud?

Marcin

Olszewski Centra danych

i rozwój aplikacji, które wspomagają naszą ofertę infrastrukturalną, to

jest nasz core biznes – w przyszłości nadal będzie kluczowy dla

Fujitsu. Chmura to jest kolejny krok w rozwoju naszej firmy. Piętnaście

czy dziesięć lat temu byliśmy w Polsce postrzegani jako producent

komputerów. Kilka lat lat temu – jako producent infrastruktury, czyli np.

serwerów i pamięci masowych. Dziś jesteśmy firmą skoncentrowaną na

rozwiązaniach, która jest w stanie zaoferować usługi i wspomagające

je aplikacje, także we współpracy z partnerami. To ewolucja

w konkretnym kierunku, a MetaArc jest na tej drodze kamieniem

milowym.

Artykuł Nie wychodzimy z rynku pecetów pochodzi z serwisu CRN.

]]>Artykuł Desktopowa sinusoida pochodzi z serwisu CRN.

]]>popyt na komputery stacjonarne zmniejszył się o kilkanaście procent.

Przyczyna była oczywista. Podczas gdy desktopy systematycznie drożały, ceny

notebooków wykazywały tendencję przeciwną. Jednak chociaż tylekroć już

wieszczono koniec komputerów stacjonarnych, nie należy obawiać się, że niedawny

spadek sprzedaży to początek „desktopowej apokalipsy”. Zdaniem producentów w tej

połowie roku należy się spodziewać znacznego ożywienia w opisywanym

segmencie rynku.

CRN Polska od kilkunastu

lat systematycznie bada rynkową sytuację komputerów stacjonarnych.

I chociaż w ciągu tego czasu wiele się zmieniło, a desktop

z monopolisty zmienił się najpierw w konstrukcję dominującą,

a następnie już tylko w jedno z wielu obecnych na rynku urządzeń

komputerowych – poczciwa stacjonarna maszyna, wpisana na stałe

w krajobraz branży, jest traktowana jako swoisty barometr jej kondycji.

Przyjrzyjmy się jej, zaczynając od konfiguracji, która w ostatnich latach

stanowi jedyny stały element w segmencie desktopów. Mowa tu oczywiście

o typowych maszynach, które stanowią 70–80 proc. sprzedaży.

– Komponenty najpopularniejszych konfiguracji to niezmiennie:

procesor Intela Core i3, 4 GB pamięci operacyjnej i dysk twardy

o pojemności 500 GB – mówi Marcin Wesołowski, Country Category

Manager w polskim przedstawicielstwie HP.

Dokładnie te same elementy

wymienili przedstawiciele wszystkich firm, z którymi rozmawialiśmy: Acera,

Asusa, Lenovo, Max Computers czy NTT System. O ile w przypadku

intelowskiego procesora Core i3 można mówić o ewolucji, bo jest dziś

jednostką czwartej lub piątej generacji, o tyle pozostałe elementy peceta

są w obecnej „formie” dobrze znane od kilku lat.

Duże spadki

Jak wspomnieliśmy,

w bieżącym roku mamy do czynienia z bardzo dużym spadkiem sprzedaży

komputerów stacjonarnych. W minionym półroczu nabywców znalazło zaledwie

370–380 tys. maszyn, wliczając konstrukcje typu All-in-One. To bardzo duża

zmiana w porównaniu z pierwszym półroczem 2014 r., gdy krajowy

rynek wchłonął prawie 450 tys. desktopów. Jeśli odliczymy komputery AiO, bilans

będzie przedstawiał się następująco: 300 tys. w pierwszej połowie br.

wobec 374 tys. rok wcześniej. Oznacza to ponad 20-procentowy spadek. To dużo,

ale zdaniem producentów jesteśmy świadkami sytuacji przejściowej, za którą

odpowiadają dwa proste czynniki: wzrost cen maszyn stacjonarnych i spadek

ceny najtańszych notebooków.

– Na spadek sprzedaży desktopów wpływ miały bardzo korzystne

cenowo oferty notebooków z systemem Windows Bing – mówi Bartosz

Zieliński, Country Product Manager w polskim przedstawicielstwie Asusa.

– Ceny notebooków zeszły poniżej psychologicznej granicy tysiąca złotych, przez co wielu klientów zdecydowało się na

zakup takiego sprzętu. Do desktopa trzeba jeszcze dokupić urządzenia

peryferyjne, w związku z czym koszt zestawu znacznie przewyższał

kwotę, jaką klient mógł po prostu wydać na gotowe rozwiązanie, czyli notebooka.

Tymczasem ceny komputerów stacjonarnych nie zmieniały się

w minionym półroczu w walutach takich jak dolar czy euro, a to

musiało oznaczać wzrost cen w złotówkach. Nasi rozmówcy zwracają uwagę, że

rok temu dolar kosztował niewiele ponad 3 zł, dziś trzeba za niego

zapłacić przeszło 20 proc. więcej. Ciekawe, że o taki właśnie odsetek

spadła sprzedaż w tym segmencie rynku…

Miniaturowa alternatywa

Potężny spadek, po raz nie

wiadomo już który, sprowokował dyskusję, czy może nie jest to przypadkiem

początek końca desktopów, które w dobie wszechobecnego sprzętu przenośnego

stają się reliktem minionej epoki. Kwestia powraca systematycznie co kilka lat

i zwykle zaraz potem sprzedaż komputerów stacjonarnych rośnie, przecząc

spekulacjom.

Jak będzie tym razem? Na

rynku nie brakuje głosów, że desktop w obecnej postaci – czyli

praktycznie niezmiennej od początków swojego istnienia – może być

w przypadku większości zastosowań z powodzeniem zastąpiony przez AiO,

maszyny typu Small Form Factor czy malutkie konstrukcje znane pod nazwą NUC

(Next Unit of Computing) albo Tiny (w przypadku Lenovo). Jednak nawet

jeśli jest w tym stwierdzeniu ziarno prawdy, wcale nie musi to oznaczać,

że dla desktopów nadchodzi czas apokalipsy.

– Małe pecety mają do pokonania bardzo długą drogę, zanim

zaistnieją w świadomości klientów jako alternatywa dla desktopów

w obudowach typu tower – mówi Michał Senkowski, Product Manager Desktop

Consumer w Acerze. – Wielu potencjalnych nabywców nadal uważa, że desktop

musi być duży i ciężki, co usprawiedliwia jego cenę.

Przedstawiciel Acera zwraca

również uwagę, że rzesza klientów nawet przy wyborze komputera przenośnego

oczekuje parametrów desktopa i wybiera ciężkie konstrukcje

z wyświetlaczami o dużych przekątnych (najpopularniejsze notebooki

mają ekrany wielkości 15,6 cala).

Także przedstawiciel Gigabyte’a, czołowego dostawcy płyt

głównych i kart graficznych w Polsce, który ma od niedawna

w ofercie miniaturowe pecety, twierdzi, że podstawową przeszkodą

w popularyzacji tego typu sprzętu jest brak świadomości użytkowników.

– W konstrukcjach typu Brix stosuje się desktopowe

procesory Core i3, i5, a nawet i7. To maszyny o funkcjonalności

pełnowartościowego peceta, a pobierają nawet 3-krotnie mniej energii –

mówi Piotr Kozieł, Sales and Technical Manager w polskim

przedstawicielstwie Gigabyte’a. – Jednak przekonanie klientów do takich

rozwiązań wymaga edukacji. Bardzo często spotykamy się z przypadkami, gdy

Brix jest mylony ze… stacją NAS czy routerem.

Brix zamknięto w obudowie o pojemności grubo

poniżej jednego litra, czyli bardzo małej, choć w wyścigu technologicznym,

którego celem jest miniaturyzacja komputera, już dawno ustawiono poprzeczkę

jeszcze wyżej.

– W styczniu 2014 roku pokazaliśmy komputer wielkości karty

kredytowej, który umożliwiał płynną rozgrywkę w FIFA w rozdzielczości

Full HD – powiedział Bruno Murzyn, PR Manager z polskiego

przedstawicielstwa AMD.

Warto zaznaczyć, że lista rozwiązań alternatywnych

w stosunku do tradycyjnych desktopów staje się coraz dłuższa.

Minikomputery są już w ofercie większości producentów.

– AiO, małogabarytowa obudowa Lenovo Tiny o pojemności

tylko 1 litra czy też PC Stick to rozwiązania, które pokazują, że desktop

może być bardzo dobrze dopasowany do oczekiwań i zastosowań klienta. Są

więc realnym zagrożeniem dla maszyn zamkniętych w klasycznych obudowach

tower czy SFF, których możliwości klienci po prostu nie wykorzystują – mówi

Łukasz Rutkowski, Business Development Manager w Lenovo.

Coraz mniej C-brandów

Polski rynek coraz bardziej upodabnia się do europejskich

pod względem pochodzenia komputerów. Kilkanaście, a nawet jeszcze kilka

lat temu co drugi sprzedany w kraju pecet był produktem małego lokalnego

dostawcy. I chociaż C-brandów wciąż ubywa, trudno przewidzieć, czy taki

trend utrzyma się w przyszłości. Przecież na początku ostatniej dekady

mieliśmy już do czynienia z sytuacją, gdy do markowego sprzętu należało

prawie 60 proc. rynku, jednak w latach 2013–2014 udział C-brandów

ponownie się zwiększył.

W minionym półroczu

sprzedaż produktów małych lokalnych dostawców zmniejszyła się bardzo gwałtownie.

Według szacunkowych danych ich udział zawiera się w przedziale od 35 do

40 proc., co oznacza rekordowo niskie notowania. Popyt na C-brandy maleje

w tym roku szybciej niż ma to miejsce w przypadku pozostałych

dostawców – sprzedano zaledwie 120–130 tys. takich „składaków”, wobec

ponad 210 tys. w pierwszej połowie 2014 r.

To właśnie spadek sprzedaży C-brandów jest odpowiedzialny za

tegoroczne zmiany na rynku desktopów, bowiem w przypadku producentów A-

i B-brandowych zmian właściwie nie odnotowano. Co więcej, niektórzy

spośród nich mogą nawet pochwalić się wzrostem. Przykładem jest Dell, który

sprzedał o ponad 4 tys. maszyn więcej niż przed rokiem i stał

się niekwestionowanym liderem rynku, osiągając wynik ponad 64 tys. komputerów,

które trafiły na polski rynek. Siłą rzeczy na drugie miejsce spadło HP, które

w pierwszych sześciu miesiącach tego roku zmniejszyło swoje udziały.

– W pierwszej połowie 2015 sprzedaliśmy 52 tys. desktopów,

w analogicznym okresie zeszłego roku 60 tys. – przyznaje Marcin

Wesołowski

Duży wzrost odnotowało Lenovo, które utrzymało zeszłoroczną

trzecią pozycję, a wynikiem na podobnym poziomie jak w I połowie

2014 r. może się pochwalić Komputronik. Spośród krajowych dostawców

również NTT System oparło się negatywnym tendencjom.

– W pierwszej połowie 2014 r. sprzedaliśmy 14,4

tys. komputerów, zaś w analogicznym okresie 2015 r. sprzedaż wyniosła

13,9 tys. – powiedział Robert Nowak, Product Manager w NTT

System.

Quo vadis pececie?

Jak wspomnieliśmy, rośnie liczba urządzeń, które mogą być

dla desktopa funkcjonalną alternatywą. Najpoważniejszą konkurencją wydaje się

AiO, a przybywa konstrukcji typu NUC oraz miniaturowych urządzeń pod nazwą

PC Stick. Nie ma jednak zgody co do tego, czy takie maszyny należy traktować

jako zamiennik stacjonarnego peceta.

– Komputerów typu AiO nie traktujemy jak alternatywy, ale

raczej jako uzupełnienie oferty tradycyjnych desktopów – mówi Robert

Nowak. – Rzeczywiście tego typu maszyny zyskują na popularności, zwłaszcza

w sektorze instytucjonalnym. Natomiast komputery typu PC Stick na pewno

znajdą swoją niszę na rynku, jednak nie powinny zagrozić desktopom.

Zdaniem przedstawiciela NTT System komputer stacjonarny ma

i będzie miał stabilną pozycję w przyszłości.

– Obecne tempo rozwoju technologii desktopowych jest

porównywalne do tego sprzed pięciu czy dziesięciu lat, więc powinno stymulować

wymianę sprzętu. Tym bardziej że komputer kosztuje coraz mniej w relacji

do przeciętnego wynagrodzenia – podsumowuje Robert Nowak.

Jesteśmy też u progu zmian w zakresie komunikacji

z pecetem

– Komputer stacjonarny będzie coraz lepiej dostosowany do

potrzeb użytkowników, którzy będą mogli korzystać w coraz większym stopniu

z naturalnych interfejsów, takich jak rozpoznawanie twarzy i gestów,

np. dzięki technologii AMD Face Login i AMD Gesture Control, zaś następnym

krokiem będzie już wirtualna rzeczywistość – mówi Bruno Murzyn.

Czy tak będzie czy nie, zobaczymy. Niemniej trzeba się

zgodzić, że powyższe argumenty przemawiają za utrzymaniem lub zwiększaniem się

udziałów desktopów w całym segmencie komputerów niż za ich zmniejszaniem.

Artykuł Desktopowa sinusoida pochodzi z serwisu CRN.

]]>