Artykuł Modernizacja IT zaczyna się od danych pochodzi z serwisu CRN.

]]>„Nowe modele informatyczne ewoluują, aby wspierać coraz bardziej ulepszoną technologię w obszarach: edge computing, data, cloud i security”- mówił Krzysztof Kowalczyk, Sales Director, HPE Polska na konferencji HPE i AMD „Modernizacja IT zaczyna się od danych”.

Jak podkreślano, dane to obecnie jeden z najważniejszych zasobów organizacji. Strategia data-first, oparta na ich efektywnym wykorzystaniu, musi być wdrażana wraz z modernizacją IT, zmianą procesów i praktyk.

Chmura publiczna nie zawsze jest dobrym rozwiązaniem

Eksperci zapewniali, że przetwarzanie i operacje na danych w miejscu ich tworzenia, głównie na brzegu sieci, doprowadzi do szybszych i bardziej wymiernych wyników biznesowych. Organizacje wciąż próbują przechowywać i przetwarzać dane w miejscu, w którym można je w pełni kontrolować. Ten paradygmat musi ulec zmianie.

Transformacja zorientowana na dane nie wymaga też przenoszenia obciążenia z maszyn lokalnych na chmurowe, gdyż dziś wciąż ponad 70 proc. aplikacji i danych znajduje się poza chmurą publiczną.

Jak zauważono, wiele organizacji przeniosło się do chmury tylko po to, by odkryć, że silosy nadal istnieją jako część architektury wielochmurowej.

Według ekspertów uelastycznienie środowisk IT zapewnia platforma HPE GreenLake. Umożliwia udostępnianie zasobów i danych w centrum danych, na brzegu sieci czy w chmurze publicznej, z jednego portalu w modelu usługowym.

Co pomaga w podejściu data-first

Na konferencji zaprezentowano nowe rozwiązania umożliwiające modernizację IT od brzegu sieci do chmury. Jak stwierdzono, rośnie potrzeba inwestowania w serwery, które zapewnią niezbędną wydajność, a jednocześnie są łatwe w zarządzaniu i elastyczne. Te wymogi spełniają według informacji z konferencji maszyny HPE ProLiant nowej, 11 generacji, na platformie AMD.

Kluczowe jest również łatwe zarządzanie i bezpieczne przechowywanie danych. Według HPE wymierne efekty przynoszą systemy dyskowe, zapewniające samoobsługę i dające 100 proc. gwarancji dostępności dla krytycznych środowisk. Rozwiązanie pamięci masowej HPE GreenLake for Block Storage jest według producenta jedynym na rynku rozwiązaniem spełniającym te parametry.

Jest to usługa zapewniająca obsługę danych w chmurze w ramach HPE GreenLake, która upraszcza zarządzanie lokalną pamięcią masową i pomaga w dostępie do danych rozproszonych w organizacji, co ułatwia szybsze podejmowanie decyzji biznesowych, przy jednoczesnym zachowaniu bezpieczeństwa..

Zaprezentowano również usługę HPE GreenLake for DataFabric, która w jednym miejscu łączy dane, aplikacje i konta użytkowników niezależnie od ich fizycznej lokalizacji – na krawędzi sieci, centrum danych czy chmury publicznej. Przyspiesza wykorzystanie danych zgromadzonych w przedsiębiorstwie.

Artykuł Modernizacja IT zaczyna się od danych pochodzi z serwisu CRN.

]]>Artykuł IT zmierza w stronę usług pochodzi z serwisu CRN.

]]>– W przypadku projektów bazujących na chmurze zmniejsza się ryzyko dla integratora, co jest związane z dużo większą elastycznością oraz skalowalnością infrastruktury. Jeżeli do tego dochodzą usługi SaaS, zmniejsza się także obawa o konieczność dostosowywania funkcjonalności „out of the box” za wszelką cenę. To duża wartość zarówno dla firm takich jak nasza, ale też dla klienta końcowego. Możemy więc mówić o efekcie win-win – podkreśla Michał Burda, CEO & Country Managing Director for Poland w DXC Technology.

Posiadać sprzęt czy korzystać z usługi?

Wprowadzając nowy model korzystania z infrastruktury, chmura publiczna zmieniła także obraz rynku dostawców sprzętu. Oprócz tradycyjnego modelu (zakup rozwiązania na własność przez klienta) od pewnego czasu promują oni także model usługowy, oferując wybrane elementy infrastruktury, takie jak Storage as a Service (StaaS) albo wręcz kompletne, rozliczane na zasadach stałych opłat Data Center as a Service (DCaaS).

Dostawcy oferujący obie opcje zwracają uwagę, że to, która forma jest w danym wypadku lepsza, zależy od wielu aspektów związanych z rodzajem infrastruktury i samym jej użytkowaniem, kosztami, w tym także przepisami prawa. Obie znajdują przy tym swoich zwolenników i przeciwników.

Według specjalistów ci, którzy stawiają na posiadanie infrastruktury, lubią mieć pełną kontrolę nad sprzętem i chcą mieć zagwarantowaną możliwość rozbudowy swoich urządzeń. Posiadanie daje im również możliwość samodzielnego amortyzowania sprzętu, co pozwala na optymalizację kosztową. Także regulacje prawne niekiedy wymuszają użytkowanie sprzętu w kraju, w bezpiecznej lokalizacji, tak aby należycie chronić dane wrażliwe, co może przemawiać za posiadaniem własnej infrastruktury.

– Z kolei w modelu usługowym użytkownicy mogą liczyć na obniżenie całkowitego kosztu posiadania infrastruktury IT, ponieważ płacą zgodnie z rzeczywistym użyciem. Szybka możliwość zwiększenia zasobów daje również większą elastyczność w reagowaniu na zmiany w otoczeniu biznesowym. Model usługowy redukuje dług technologiczny i umożliwia przeniesienie kosztów kapitałowych, czyli CapEx, na wydatki związane z utrzymaniem systemów IT, czyli OpEx – podkreśla Michał Gazda, Account Executive w Dell Technologies.

Modele usługowe i konsumpcyjne, takie jak „pay as you go”, umożliwiają korzystanie z zaawansowanych technologii, najnowszego i zawsze aktualnego oprogramowania. Dlatego idea „płać za to, co wykorzystujesz” dobrze sprawdza się w codziennej działalności biznesowej. Ważnym atutem takich rozwiązań ma być również to, że użytkownik dostaje kompleksowe wsparcie ze strony producenta.

– Natomiast z punktu widzenia integratorów jest to koncepcja bardziej finansowa niż technologiczna. Co ważne, dobrze rozumiana przez decydentów analizujących aspekty ekonomiczne projektów IT. Z ich punktu widzenia propozycje pozwalające na połączenie zalet tradycyjnych rozwiązań z wygodnym modelem rozliczeniowym są korzystne – mówi Michał Grzegorzewski, dyrektor działu usług w Fujitsu.

Model „pay as you go” może być oferowany zarówno w odniesieniu do kompleksowych rozwiązań przeznaczonych dla centrów danych, jak i niewielkich, lokalnych serwerowni. Rozwiązania w tym modelu są na tyle elastyczne, że można stosować je już w przypadku stosunkowo niewielkich, precyzyjnie dopasowanych projektów. Tacy dostawcy, jak HPE, od lat przekonują, że świat IT będzie hybrydowy, a klienci oczekują całościowych i elastycznych rozwiązań, pozwalających jak najefektywniej wykorzystać hybrydowe IT.

– Trudno więc jest zdecydowanie powiedzieć, który z modeli zakupowych jest lepszy. Powinniśmy się raczej zastanowić, jak oba modele mogą ze sobą współistnieć lub wręcz starać się je połączyć, tworząc hybrydowe IT – twierdzi Marek Hojda, Channel & Ecosystems Sales Manager w HPE.

Klientom w chmurze trzeba pomóc Jak wynika z badania „2022 State of Cloud Report”, przeprowadzonego przez Pluralsight, trzy czwarte liderów IT twierdzi, że rozwija już wszystkie nowe produkty i funkcje w chmurze, jednak zaledwie 8 proc. pracowników IT ma znaczące umiejętności i doświadczenie z nią związane. Aż 64 proc. respondentów przyznaje, że jest w temacie chmury „zielona” – dopiero zaczęli się uczyć i chcą pozyskać podstawowe umiejętności. Choć pracownikom IT brakuje umiejętności chmurowych, ich rozwój w tym zakresie wewnątrz firmy nie należy do priorytetów przedsiębiorstw. Tylko 37 proc. uznaje takie działanie za kluczowe. Co istotne, wiedza dotycząca bezpieczeństwa okazuje się głównym wyzwaniem, niezależnie od chmurowej dojrzałości danej firmy. Tak dużej luki kompetencyjnej w zakresie chmury przedsiębiorstwa nie będą w stanie wypełnić samodzielnie. Niezbędna okaże się pomoc doświadczonych integratorów, którzy wdrażają środowiska chmurowe i zarządzają nimi.

Artykuł IT zmierza w stronę usług pochodzi z serwisu CRN.

]]>Artykuł Suse nagrodziło partnerów w Polsce pochodzi z serwisu CRN.

]]>Suse uhonorowało partnerów, działających na polskim rynku.

Oto laureaci nagród

„Partner of the Year”

Linux Polska

Simplicity

„Distributor of the Year”

Ingram Micro

„Technology Partner of the Year”

Hewlett Packard Enterprise

Nagrodzonym serdecznie gratulujemy!

Artykuł Suse nagrodziło partnerów w Polsce pochodzi z serwisu CRN.

]]>Artykuł HPE GreenLake for Block Storage, pamięć masowa dostępna jako usługa pochodzi z serwisu CRN.

]]>Z pomocą przychodzi model „IT as-a-service”, który HPE z powodzeniem realizuje u klientów, dzięki platformie HPE GreenLake.

Jedna z ostatnich nowości w ofercie, HPE GreenLake for Block Storage, pamięć masowa dostępna jako usługa, została stworzona właśnie po to, by odpowiedzieć na kluczowe potrzeby coraz większej grupy klientów – samoobsługa, łatwość konfiguracji, 100% dostępność dla kluczowych aplikacji i płatność zależna od zużycia.

Jakie są praktyczne aspekty i szczegóły technologiczne tego rozwiązania? Zapraszamy na eksperckie e-seminarium – zarejestruj się tutaj.

Artykuł HPE GreenLake for Block Storage, pamięć masowa dostępna jako usługa pochodzi z serwisu CRN.

]]>Artykuł Pamięciom masowym kryzys niestraszny? pochodzi z serwisu CRN.

]]>Marketingowe slogany zachęcające do zrezygnowania z taśm lub nawet napędów HDD na rzecz dysków półprzewodnikowych, bądź przenoszenia wszystkich zasobów cyfrowych z własnej serwerowni do chmury publicznej, jak na razie działają na nielicznych. Większość szefów IT podejmuje decyzje bez emocji, co oddają statystki sprzedaży sprzętu oraz nośników. Jeśli już firmy decydują się na wdrożenie nowinek technicznych bądź migracji do chmury, najczęściej wybierają model hybrydowy.

Jak wynika z raportu IDC w pierwszym kwartale br. globalny rynek systemów pamięci masowych dla klientów korporacyjnych wzrósł o 2 proc. rok do roku. Jednak popyt w poszczególnych częściach świata nie był równomierny. Zakłócenia w łańcuchach dostaw, inwazja Rosji na Ukrainę oraz inflacja należały do czynników hamujących wzrost rynku.

Analitycy dostrzegają też jednak pozytywne symptomy, które powinny ożywić w najbliższych miesiącach sprzedaż pamięci masowych. Na pierwszym miejscu wymieniają znaczny wzrost zapotrzebowania na powierzchnią dyskową, a następnie transformację cyfrową oraz potrzebę usprawnienia prowadzonych przez firmy analiz biznesowych, jak też zwiększenie produktywności pracowników i poprawę jakości obsługi klienta. Z kolei największe obawy budzą ograniczona podaż oraz inflacja.

Niestety, przedłużająca się wojna w Ukrainie wpływa na sprzedaż sprzętu w sposób bezpośredni oraz pośredni. W tym pierwszym przypadku ciągnie w dół przychody osiągane przez producentów w Europie Środkowo-Wschodniej. Konflikt wywindował przy tym ceny energii i koszty transportu, co odbiło się na branży IT.

Co jednak ważne, analitycy IDC postrzegają rynek systemów pamięci masowych jako dość odporny na negatywne czynniki. Jako jeden z głównych powodów takiego stanu rzeczy wymieniają cyfrową transformację bazującą na danych. Koniunkturę na macierze dyskowe napędzają też przyrost ilości cyfrowych zasobów, zwiększone wymagania w zakresie ochrony informacji, a także obsługi krytycznych zadań obliczeniowych. Według prognoz IDC globalny rynek zewnętrznych systemów pamięci masowych będzie rósł w latach 2021–2026 w średnim tempie 4,4 proc. rocznie. Przy czym największa dynamika wzrostu przypadnie na lata 2022 (5 proc.) oraz 2023 (4,8 proc.).

SAN wciąż na fali

Rodzimi przedsiębiorcy od lat inwestują w macierze podłączane do sieci SAN. Wprawdzie w ostatnich latach pojawiły się alternatywy w postaci infrastruktury hiperkonwergentnej, systemów klasy Software Defined Storage (SDS) czy usług chmurowych, jak chociażby Amazon Elastic Block Store, ale też wiele firm nadal preferuje klasyczne rozwiązania.

Macierze SAN są cenione za wydajność, skalowalność oraz stosunkowo dużą odporność na awarie. Sprzęt ten zazwyczaj służy do hostingu baz danych, ale zdaje również egzamin w przedsiębiorstwach korzystających z wirtualnych serwerów bądź desktopów (VDI). Znaczne ożywienie w tym segmencie rynku przyniosło pojawienie się macierzy z wyłącznie półprzewodnikowymi dyskami (all-flash). Niegdyś, ze względu na wysoki koszt jednostki pojemności, były one zarezerwowane głównie dla instytucji finansowych bądź wielkich korporacji, ale wraz ze spadkiem cen nośników SSD, a także zmianami w architekturze macierzy dyskowych, sytuacja uległa zasadniczej zmianie.

– U nas udział systemów all-flash w całościowej sprzedaży macierzy dyskowych wynosi około 70 proc. Po tego typu rozwiązania sięgają przede wszystkim klienci korzystający z wirtualizacji. Natomiast urządzenia z dyskami NL-SAS wybierane są do celów archiwizacji, składowania danych z monitoringu czy backupu. W przypadku macierzy zapewniających podstawową funkcjonalność i stosunkowo niewielkie pojemności, różnice w cenach pomiędzy modelami z modułami all-flash a wersją z dyskami SAS nie są zbyt duże – mówi Tomasz Spyra, CEO Rafcomu.

Obecnie wszyscy liczący się producenci oferują macierze z nośnikami NVMe, które prawdopodobnie zaczną wypierać modele wyposażone w SSD z interfejsem SAS. Systemy uzbrojone w nowoczesne dyski gwarantują opóźnienia poniżej 100 mikrosekund i przepustowość liczoną w dziesiątkach gigabajtów, a jednocześnie realizują miliony operacji wejścia-wyjścia na sekundę (IOPS).Oprócz wyraźnego zwrotu w stronę NVMe, popularyzują się usługi zarządzania sprzętem za pośrednictwem chmury.

– Producenci sprzętu aktywnie rozwijają taki model. To zmiana, która czeka nas w niedalekiej przyszłości. Oczywiście u niektórych klientów budzi to obawy o poufność informacji. Jednak należy podkreślić, że w ramach takiej usługi zbierane są tylko dane telemetryczne, a nie te przechowywane na urządzeniach – podkreśla Grzegorz Korus, inżynier wsparcia technicznego w polskim oddziale Exclusive Networks.

Wiele wskazuje na to, że nadchodzące lata mogą być trudne dla rozwiązań klasy high-end, co wynika ze zmian, jakie miały miejsce w ofercie sprzętu klasy midrange. Macierze ze średniej półki umożliwiają chociażby rozbudowę typu scale-out (równoległy wzrost pojemności i wydajności) oraz obsługę rozproszonych klastrów. Producenci dążą do unifikacji produktów, o czym świadczy wprowadzanie wspólnych systemów operacyjnych dla całych linii produktowych, co powinno sprzyjać sprzedaży tego typu sprzętu.

Artykuł Pamięciom masowym kryzys niestraszny? pochodzi z serwisu CRN.

]]>Artykuł Cisco na plusie, spadek HPE. Przełączniki trzymają tempo wzrostu pochodzi z serwisu CRN.

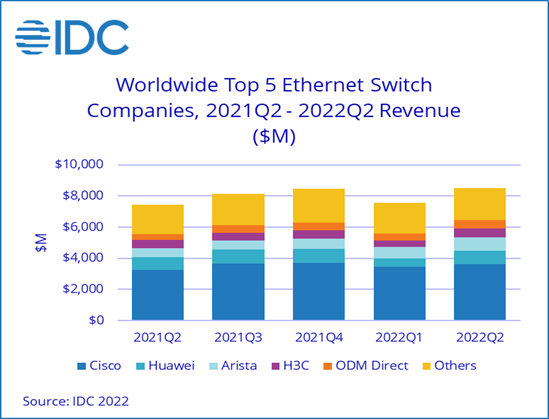

]]>Mimo zakłóceń w łańcuchu dostaw, inflacji i wojny na Ukrainie switche ethernetowe na globalnym rynku nadal schodzą w niezłym tempie.

Światowa sprzedaż przełączników wzrosła o 14,6 proc. r/r w II kw. 2022 r., do wartości 8,5 mld dol. W wojennym kwartale podkręconej inflacji było więc nawet lepiej niż w I kw. 2022 r., gdy wynik był 12,7 proc. r/r na plusie.

„Odporność tempa wzrostu rynku przełączników ethernet w ostatnich kwartałach pokazuje znaczenie łączności i infrastruktury cyfrowej w świecie biznesu zorientowanym na cyfryzację” – komentuje Brad Casemore, wiceprezes ds. badań w IDC.

W Europie Zachodniej rynek w II kw. br. urósł wartościowo podobnie jak na świecie, o 14,8 proc. r/r. W regionie CEE spadł natomiast o 12,5 proc., ale tutaj IDC do średniej jak zwykle liczy Rosję, która miała spadek o blisko 90 proc. r/r (skoro nie 100 proc., to nawet na wojnie jakieś switche ktoś tam dostarcza).

Przedsiębiorstwa też wydają więcej

W kampusie wzrost wydatków na przełączniki jest podtrzymywany przez przedsiębiorstwa dążące do cyfrowej transformacji i odporności – wynika z raportu. Wartość sprzedaży switchy globalnie poza centrami danych wzrosła jednocyfrowo, o 5,8 proc. r/r, podczas gdy w przeliczeniu na porty było podobnie jak w ub.r. (-0,4 proc. r/r).

Tymczasem w data center te liczby wyniosły odpowiednio 26,9 proc. r/r oraz 11,7 proc. r/r na plusie w II kw. 2022 r.

Ponieważ wyniki ciągną w górę hiperskalowe centra danych i dostawcy usług w chmurze, przychody z przełączników 200/400 GbE wzrosły najbardziej, o ponad 67 proc. w jeden kwartał (wobec I kw. 2022 r.), a na liczbie portów o blisko 90 proc.

2,5/5GbE dostały przyspieszenia

Na switchach 1GbE poprawa była nieznaczna: 2,6 proc. na przychodach i 1,6 proc. w liczbie portów, a 10GbE spadły o 1,3 proc., podczas gdy liczba przesyłek liczona w portach wzrosła o 2,1 proc. r/r w II kw. br.

Warto natomiast zauważyć, że rynek br. wchłania znacznie więcej przełączników wielogigabitowych 2,5/5GbE – gdzie wzrost przychodów w II kw. br. sięgnął 41,2 proc. r/r, a wysyłek o 58,7 proc.

Cisco ze wzrostem, choć niższym niż rynek

Cisco naturalnie pozostaje dominatorem na rynku przełączników ethernet z 42,3 proc. globalnego udziału w II kw. br. (wartościowo), po wzroście o 10,2 proc., czyli niższym niż średnia dla rynku.

Drugi Huawei poprawił się o 9,4 proc., co daje firmie 10,6 proc. udziału.

Arista Networks wystrzeliła w górę o 55 proc. r/r i jest już na podium tuż za Huawei (10,1 proc. udziału w światowym rynku).

Skromny wzrost H3C (+4,3 proc.) dał mu udział na poziomie 6,3 proc.

Przychody HPE z przełączników ethernet spadły w II kw. br. o 5,5 proc., co przełożyło się na udział na poziomie 5,5 proc.

Artykuł Cisco na plusie, spadek HPE. Przełączniki trzymają tempo wzrostu pochodzi z serwisu CRN.

]]>Artykuł Szef HPE powątpiewa w wynik Dell Apex pochodzi z serwisu CRN.

]]>Dell Technologies poinformował w wynikach za swój II kw. finansowy, iż jego roczny przychód cykliczny (ARR – annual recurring revenue) z działalności Apex przekroczył 1 mld dol. Są to rozwiązania infrastruktury rozliczane w modelu as-a-service.

CEO HPE Antonio Neri nie kryje swoich wątpliwości wobec takiego wyniku. Utrzymuje, że Dell nie ma możliwości platformy edge-to-cloud ani siły kanału sprzedaży, aby zmierzyć się z GreenLake, czyli biznesem as-a-service od HPE.

Dla porównania HPE Greenlake osiągnął w minionym kwartale wskaźnik ARR na poziomie 858 mln dol., po wzroście 28 proc. r/r. HPE mierzy siłę biznesu GreenLake za pomocą wskaźnika Annualized Revenue Run-Rate, używanego do oceny wzrostu.

„Działanie w modelu as-a-service nie jest łatwe, ponieważ potrzeba do tego platformy, która ma odpowiednie możliwości. Jej zbudowanie zajmuje dużo czasu” – twierdzi Antonio Neri dla CRN USA.

Dodaje, że chciałby zobaczyć dokładną definicję, której Dell używa do określania przychodów Apex.

Rzecznik Della poinformował według CRN USA, że cykliczne przychody Apex stanowią cykliczne przychody netto z subskrypcji marki Apex, ofert w ramach usługi i opartych na użytkowaniu. Dodał przy tym, że nie obejmują one przychodów z tych ofert, które są rozpoznawane z góry w wyniku leasingu typu sprzedażowego.

CEO HPE Antonio Neri nie pierwszy raz głośno wyraża swój sceptycyzm wobec działań Dell Technologies.

W końcu 2021 r. oceniał, że Dell nie jest konkurentem dla HPE w modelu as-a-service.

„Wierzymy, że mamy lata przewagi” – twierdził, dodając że Dell „prawdopodobnie nie ma nic do pokazania”, jeśli chodzi o wyniki Apex.

W 2018 r. Antonio Neri utrzymywał również np., że „Dell nie ma strategii dotyczącej rozwiązań brzegowych”.

Według raportu Della za II kw. producent widzi „dużą siłę” w swoich niestandardowych rozwiązaniach Apex, w tym Flex On Demand. Wskazuje również na wzrost obejmujący ofertę Apex wykorzystywaną w centrum danych, polegającą na przeniesieniu całości lub części data center do zarządzanego przez Della modelu płatności pay-per-use.

Źródło: CRN USA

Artykuł Szef HPE powątpiewa w wynik Dell Apex pochodzi z serwisu CRN.

]]>Artykuł Nowy program partnerski HPE promuje model as-a-service pochodzi z serwisu CRN.

]]>Program HPE Partner Ready Vantage jest odpowiedzią na zachodzące zmiany rynkowe, w wyniku których zamiast tradycyjnego podejścia klienci domagają się obecnie bardziej elastycznego, pozwalającego jak najefektywniej wykorzystać potencjał IT. Odpowiedzią mają być rozwiązania w formie usługi, w ramach których klienci płacą tylko za to, co wykorzystują. Nowy program, niezależnie od tego, jak bardzo zaawansowany jest partner w swojej transformacji w stronę modelu as-a-service, ma umożliwiać mu poszerzanie lub doskonalenie kompetencji w tym obszarze.

HPE Partner Ready Vantage jest podzielony na trzy ścieżki: The Build Track, The Sell Track i The Service Track. Każda z tych ścieżek posiada własne COE (Center of Expertise) oferujące dostosowane do potrzeb szkolenia, inicjatywy rynkowe i narzędzia sprzedażowe.

Nowy, zunifikowany program partnerski i odświeżony portal obejmują portfolio HPE i Aruba. Udoskonalona obecnie cyfrowa platforma Partner Connect ułatwia nawiązywanie kontaktów nie tylko z klientami, ale również z innymi partnerami.

Artykuł Nowy program partnerski HPE promuje model as-a-service pochodzi z serwisu CRN.

]]>Artykuł HPE przegrywa w sądzie z Oracle’m. Ma zapłacić 30 mln dol. pochodzi z serwisu CRN.

]]>HPE dostarczał klientom aktualizacje systemu operacyjnego Solaris bez zgody Oracle’a – uznał kalifornijski sąd. Wyrok nakazuje zapłatę 30 mln dol. za naruszenie praw autorskich.

Oracle domagał się 72 mln dol. Twierdził, że HPE bezprawnie dostarczało aktualizacje software’u Oracle’a klientom, którzy nie mieli umów wsparcia na Solarisa. Pierwszy pozew w tej sprawie złożono w 2016 r.

Dodatkowo orzeczono wprawdzie 24 mln dol. za wyrządzone szkody, jednak sąd uznał, że HPE ma uiścić jedynie wspomniane 30 mln dol.

HPE nie zgadza się z wyrokiem i rozważa dalsze kroki (może złożyć apelację). Koncern utrzymuje, że problem nie miał takiej skali, jak to przedstawia Oracle.

Według Oracle’a HPE dostarczając nielegalne łatki miało współpracować z Terixem, firmą zajmującą się wsparciem oprogramowania. Prawnicy Oracle’a zajęli się Terixem już w 2013 r. W 2018 r. szef firmy został skazany na 2 lata za oszustwa, w tym za nielegalne wsparcie Solarisa.

3 mld dol. w sprawie sprzed lat

Jednakże Oracle ma zapłacić HPE dużo więcej – aż 3 mld dol. W maju br. amerykański sąd najwyższy odrzucił wniosek Oracle’a o apelację w tej sprawie. HPE pozwało koncern software’owy lata temu twierdząc, że wbrew umowie zakończył wsparcie dla serwerów HP Itanium. Stało się to w 2011 r., czyli sprawa długo już krąży po sądach.

Według HPE Oracle miał zgodnie z zapisami umowy wspierać produkty zbudowane na platformie Intel Itanium, ale po jakimś czasie przestał tworzyć oprogramowanie pod te procesory, argumentując, iż Intel zrezygnował z ich rozwoju.

Artykuł HPE przegrywa w sądzie z Oracle’m. Ma zapłacić 30 mln dol. pochodzi z serwisu CRN.

]]>Artykuł HCI, czyli szwajcarski scyzoryk w centrum danych pochodzi z serwisu CRN.

]]>Nieraz HCI porównuje się do smartfona albo szwajcarskiego scyzoryka. Ta trafna paralela bardzo dobrze obrazuje rolę tej architektury w centrach danych, choć byłoby sporym nadużyciem stwierdzenie, że infrastruktura hiperkonwergentna osiągnęła tak spektakularny sukces rynkowy, jak na przykład inteligentne telefony. Nie udało się jej wypchnąć z centrów danych macierzy SAN, co kilka lat temu zapowiadali prekursorzy tej technologii. Co nie zmienia faktu, że administratorzy pod postacią HCI otrzymują produkt przyjazny i łatwy w obsłudze. Zamiast z osobna zarządzać mocą obliczeniową, pamięcią masową i siecią, zyskują dostęp do jednolitej infrastruktury IT.

Jednak ułatwienie dla adminów to nie jedyny powód, dla którego przedsiębiorstwa inwestują w infrastrukturę hiperkonwergentną. Przyczyny mogą być bardzo różne, w zależności od potrzeb i wielkości firmy, aczkolwiek warto wskazać przynajmniej trzy podstawowe korzyści, jakie niesie ze sobą inwestycja w „pudełko”. HCI bardzo często określa się jako technologię pod klucz. Nawet jeśli jest w tym nieco przesady, łatwość wdrożenia stanowi jeden z największych atutów tej architektury. W związku z tym, że poszczególne elementy składowe rozwiązania – serwer, pamięć masowa oraz potencjalnie sieć i wirtualizacja — są wstępnie zainstalowane i skonfigurowane przez dostawcę, system HCI jest łatwiejszy do wdrożenia niż każde urządzenie z osobna.

Kolejnym atutem jest elastyczność rozwiązania. Przy czym analitycy z Forrestera zauważają, że architektura hiperkonwergentna jest elastyczna zarówno pod względem sposobu wdrażania, jak i zakupu. Firmy mogą kupować HCI jako samodzielne systemy od dostawców, budować własne, a nawet polegać na systemach definiowanych programowo. Nie można też zapominać o kosztach: różnego rodzaju analizy pokazują zmniejszenie wydatków OPEX o 30 proc. i 20 proc. w przypadku nakładów inwestycyjnych w porównaniu z tradycyjną infrastrukturą IT (choć niektórzy widzą to inaczej, o czym w dalszej części artykułu).

Oszczędności wynikające z zastosowania HCI pochodzą z dwóch głównych obszarów: pojedynczego pozyskiwania komponentów sprzętowych – w tym wymiany niektórych elementów sprzętowych na architekturę zdefiniowaną programowo – oraz z niższych kosztów instalacji i unifikacji zarządzania. To ostatnie wyraźnie wyróżnia systemy hiperkonwergentne na tle rozwiązań konkurencyjnych. Architektura, w której poszczególne komponenty są zdefiniowane przez oprogramowanie, może działać jak pojedyncze rozwiązanie. Zunifikowane zarządzanie powoduje też ograniczenie liczby narzędzi potrzebnych do obsługi infrastruktury IT i powinno zmniejszyć wymagania szkoleniowe – zespoły IT nie muszą uczyć się technologii i aplikacji pochodzących od wielu dostawców.

Zdaniem integratora

Deprecated: Creation of dynamic property Timber\Post::$_edit_lock is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_edit_last is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$obrazek_wyrozniajacy is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_obrazek_wyrozniajacy is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_author is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$galeria is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_galeria is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$link_obrazka_wyrozniajacego is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_link_obrazka_wyrozniajacego is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$thumbnail_video is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_thumbnail_video is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_content_score is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_estimated-reading-time-minutes is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_primary_category is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_views_count is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_thumbnail_id is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_focuskw is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_linkdex is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_date_gmt is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$comment_status is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$ping_status is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_password is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_name is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$to_ping is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$pinged is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_modified is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_modified_gmt is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_content_filtered is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$guid is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$menu_order is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_mime_type is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$comment_count is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$filter is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$status is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_edit_lock is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_thumbnail_id is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_edit_last is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_focuskw is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_linkdex is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_content_score is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_estimated-reading-time-minutes is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$obrazek_wyrozniajacy is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_obrazek_wyrozniajacy is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_author is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$galeria is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_galeria is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$link_obrazka_wyrozniajacego is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_link_obrazka_wyrozniajacego is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$thumbnail_video is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_thumbnail_video is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_primary_category is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_views_count is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_date_gmt is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$comment_status is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$ping_status is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_password is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_name is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$to_ping is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$pinged is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_modified is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_modified_gmt is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_content_filtered is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$guid is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$menu_order is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_mime_type is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$comment_count is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$filter is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$status is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_edit_lock is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_thumbnail_id is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_edit_last is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$obrazek_wyrozniajacy is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_obrazek_wyrozniajacy is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_author is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$galeria is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_galeria is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$link_obrazka_wyrozniajacego is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_link_obrazka_wyrozniajacego is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$thumbnail_video is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_thumbnail_video is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_primary_category is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_focuskw is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_linkdex is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_content_score is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_estimated-reading-time-minutes is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_views_count is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_date_gmt is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$comment_status is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$ping_status is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_password is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_name is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$to_ping is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$pinged is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_modified is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_modified_gmt is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_content_filtered is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$guid is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$menu_order is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_mime_type is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$comment_count is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$filter is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$status is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_edit_lock is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_edit_last is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_focuskw is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_linkdex is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_content_score is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_estimated-reading-time-minutes is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$obrazek_wyrozniajacy is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_obrazek_wyrozniajacy is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_author is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$galeria is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_galeria is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$link_obrazka_wyrozniajacego is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_link_obrazka_wyrozniajacego is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$thumbnail_video is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_thumbnail_video is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_primary_category is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_thumbnail_id is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_views_count is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_date_gmt is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$comment_status is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$ping_status is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_password is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_name is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$to_ping is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$pinged is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_modified is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_modified_gmt is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_content_filtered is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$guid is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$menu_order is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_mime_type is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$comment_count is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$filter is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$status is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_edit_lock is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_thumbnail_id is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_edit_last is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_focuskw is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_linkdex is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_content_score is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_estimated-reading-time-minutes is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$obrazek_wyrozniajacy is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_obrazek_wyrozniajacy is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_author is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$galeria is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_galeria is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$link_obrazka_wyrozniajacego is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_link_obrazka_wyrozniajacego is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$thumbnail_video is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_thumbnail_video is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_primary_category is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_views_count is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_date_gmt is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$comment_status is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$ping_status is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_password is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_name is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$to_ping is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$pinged is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_modified is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_modified_gmt is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_content_filtered is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$guid is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$menu_order is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_mime_type is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$comment_count is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$filter is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$status is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_edit_lock is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_edit_last is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$obrazek_wyrozniajacy is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_obrazek_wyrozniajacy is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_author is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$galeria is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_galeria is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$link_obrazka_wyrozniajacego is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_link_obrazka_wyrozniajacego is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$thumbnail_video is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_thumbnail_video is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_content_score is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_estimated-reading-time-minutes is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_primary_category is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_focuskw is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_linkdex is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_thumbnail_id is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_views_count is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_date_gmt is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$comment_status is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$ping_status is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_password is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_name is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$to_ping is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$pinged is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_modified is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_modified_gmt is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_content_filtered is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$guid is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$menu_order is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_mime_type is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$comment_count is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$filter is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$status is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_edit_lock is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_edit_last is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$obrazek_wyrozniajacy is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_obrazek_wyrozniajacy is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_author is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$galeria is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_galeria is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$link_obrazka_wyrozniajacego is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_link_obrazka_wyrozniajacego is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$thumbnail_video is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_thumbnail_video is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_primary_category is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_content_score is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_estimated-reading-time-minutes is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_thumbnail_id is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_views_count is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_focuskw is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_linkdex is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_date_gmt is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$comment_status is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$ping_status is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_password is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_name is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$to_ping is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$pinged is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_modified is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_modified_gmt is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_content_filtered is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$guid is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$menu_order is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_mime_type is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$comment_count is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$filter is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$status is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_edit_lock is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_thumbnail_id is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_edit_last is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_focuskw is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_metadesc is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_linkdex is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_content_score is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_estimated-reading-time-minutes is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$obrazek_wyrozniajacy is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_obrazek_wyrozniajacy is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_author is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$galeria is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_galeria is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$link_obrazka_wyrozniajacego is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_link_obrazka_wyrozniajacego is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$thumbnail_video is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_thumbnail_video is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_primary_category is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_views_count is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_date_gmt is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$comment_status is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$ping_status is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_password is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_name is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$to_ping is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$pinged is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_modified is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_modified_gmt is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_content_filtered is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$guid is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$menu_order is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_mime_type is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$comment_count is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$filter is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$status is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_edit_lock is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_edit_last is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$obrazek_wyrozniajacy is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_obrazek_wyrozniajacy is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_author is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$galeria is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_galeria is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$link_obrazka_wyrozniajacego is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_link_obrazka_wyrozniajacego is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$thumbnail_video is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_thumbnail_video is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_primary_category is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_focuskw is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_linkdex is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_content_score is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_estimated-reading-time-minutes is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_thumbnail_id is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_views_count is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_date_gmt is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$comment_status is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$ping_status is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_password is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_name is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$to_ping is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$pinged is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_modified is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_modified_gmt is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_content_filtered is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$guid is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$menu_order is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$post_mime_type is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$comment_count is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$filter is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$status is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_edit_lock is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_thumbnail_id is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_edit_last is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_focuskw is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_linkdex is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_content_score is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_yoast_wpseo_estimated-reading-time-minutes is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$obrazek_wyrozniajacy is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_obrazek_wyrozniajacy is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_author is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$galeria is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71

Deprecated: Creation of dynamic property Timber\Post::$_galeria is deprecated in /home/sarotaq/crn/wp-content/plugins/timber-library/lib/Core.php on line 71